Blog - Deutsch

Erkenntnisse und Ideen von den besten Analytics-Experten.- RSS-Feed abonnieren

- Als neu kennzeichnen

- Als gelesen kennzeichnen

- Lesezeichen

- Abonnieren

- Drucker-Anzeigeseite

- Moderator informieren

- RSS-Feed abonnieren

- Als neu kennzeichnen

- Als gelesen kennzeichnen

- Lesezeichen

- Abonnieren

- Drucker-Anzeigeseite

- Moderator informieren

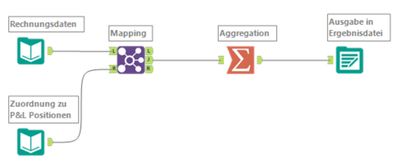

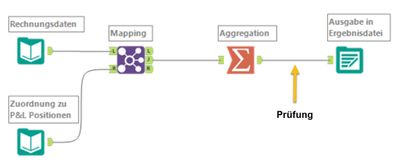

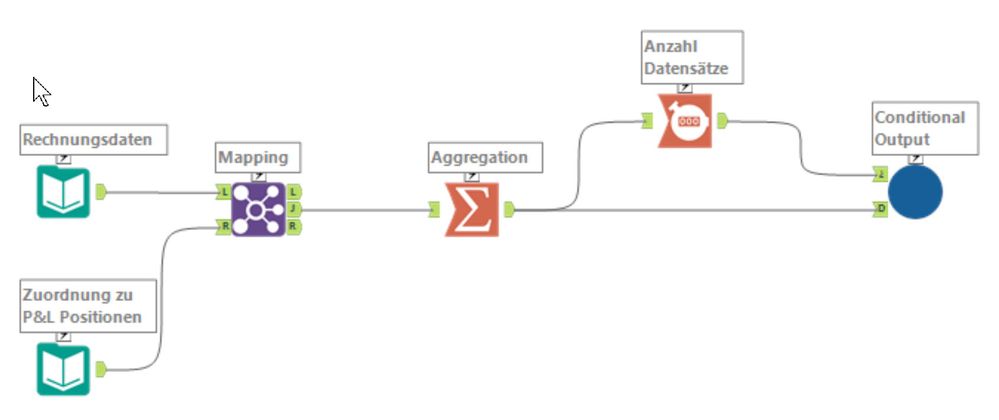

Jeden Tag werden aktuelle Daten in Tabellen und/oder Dateien bereitgestellt. Diese Daten werden mit einem Alteryx-Workflow verarbeitet - beispielsweise werden einzelne Buchungssätze auf Kontenebene in einer SQL-Tabelle geliefert, diese werden dann mit einer Tabelle verkünpft, die eine Zuordnung zu den entsprechenden P&L-Positionen enthält, dann wird auf Positionsebene aggregiert und das Ergebnis schließlich als Datei/Bericht ausgegeben. Vielleicht sind es auch Umsatzdaten, die um eine Warengruppe ergänzt werden, oder von Tochtergesellschaften im lokalen Kontenrahmen bereitgestellte Abschlussdaten, die auf die entsprechenden Konzernkonten gemappt werden sollen. Diesen oder einen ähnlichen Ablauf kennt ja möglicherweise der eine oder andere und eigentlich ist das auch keine große Herausforderung.

Allerdings soll es ja hier oder da vorkommen, dass mal etwas nicht funktioniert ... so etwas soll ja vorkommen. Was zum Beispiel passiert, wenn etwa die Tabelle, die die Zuordnungen enthält, keine Daten beinhaltet? In diesem Fall kann noch nicht einmal ein Alteryx-Workflow ein brauchbares Ergebnis liefern! Die 0 Datensätze werden aber trotzdem in die angegebene Output-Datei/-Tabelle geschrieben. Resultat: Eine leere Datei oder Tabelle.

Nicht nur, dass es keine aktuellen Daten gibt, auch die nicht ganz so aktuellen Daten aus dem letzten Lauf sind weg. Diese Situation kann in ganz unterschiedlichen Formen auftreten. Im Beispiel haben wir es mit der eher "harmlosen" Variante zu tun - es fällt sicherlich sehr schnell auf, dass die Datei leer ist, und das Problem kann einfach gelöst werden, indem eine korrekte (= gefüllte) Zuordnungstabelle bereitgestellt wird.

Manchmal ist das aber nicht so einfach, bis zur Entdeckung des Fehlers vergeht viel Zeit oder es gehen sogar Daten verloren. In diesem Fall wäre es doch sinnvoll, zwischen "Aggregation" und "Ausgabe in Ergebnisdatei" zunächst zu prüfen, ob Daten vorhanden sind, und nur, wenn diese Bedingung erfüllt ist, die Ergebnisdatei zu aktualisieren.

Aber wie können wir das nun umsetzen? Vielleicht finden wir ja eine Lösung, inden wir in Alteryx einfach mal nach "condition" suchen, wenn es um Bedingungen geht, könnte das doch passen!

Und tatsächlich, es gibt sogar ein Condition Tool. Die Tool allerdings gehört in die Palette "Interface" - wir werden also wohl ein Macro oder eine Analytic App bauen müssen. Für den konkreten Anwendungsfall bietet sich an, ein Makro zu bauen, das Output Data Tool gewissermaßen so zu "verpacken", das unser Problem mit der Bedingung gelöst wird.

Also - los geht's. Wir öffnen einen neuen Workflow und ziehen das Condition Tool auf den Canvas. Das Tool hat einen Questions Anchor, hier können wir in unserem Fall die Anzahl der Ergebnisdatensätze "einspeisen".

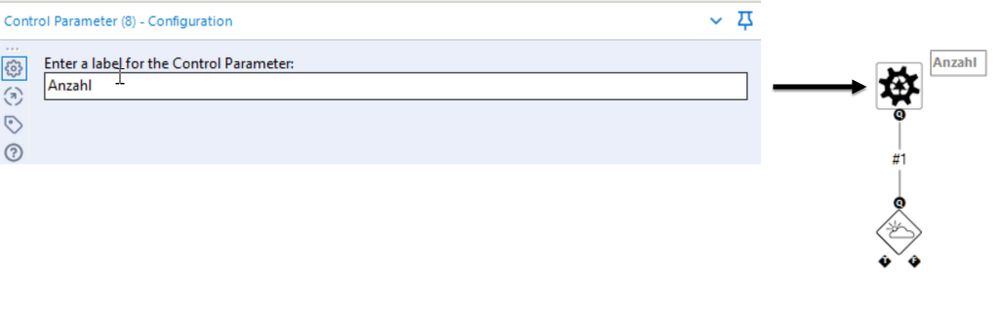

Diese Anzahl (oder auch einen anderen Wert, der geprüft werden soll) können wir ganz einfach über ein Control Parameter Tool anliefern. Dem Tool müssen wir nur ein Label mitgeben (also eine Bezeichnung für den Wert, der da geliefert werden soll). Hier bietet es sich natürlich an, den Parameter gleich "Anzahl" zu nennen.

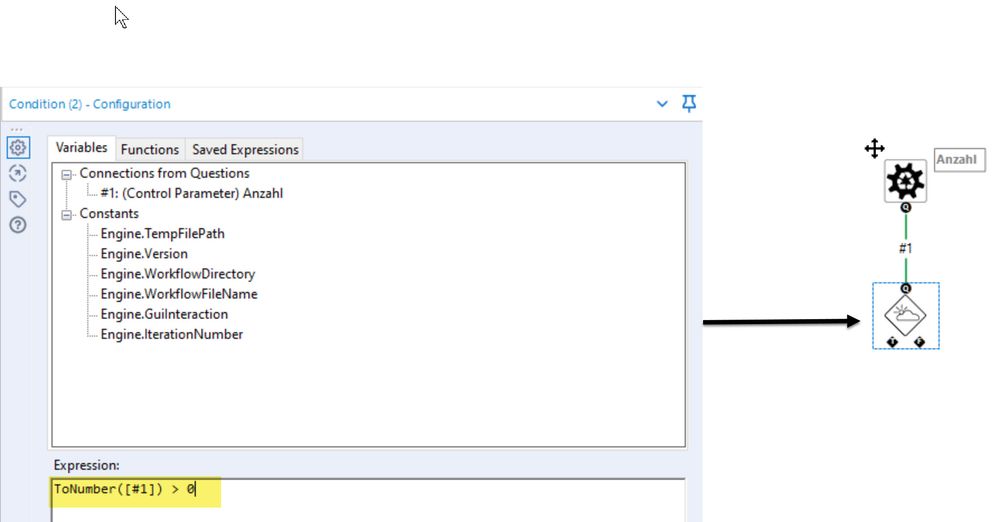

Die "Input-Seite" wäre damit erledigt. Auf der "Output-Seite" gibt es einen "T" und einen "F" Anchor, die abhängig von der Prüfung der Bedingung angesteuert werden. Diese Bedingung kann dazu im Condition Tool hinterlegt werden. Im konkreten Fall prüfen wir, ob der angelieferte Wert (also die Anzahl Datensätze) größer als 0 ist. Der Parameter wird als Variable über "Connections from Questions" übergeben. Diese werden einfach nummeriert - in unserem Fall gibt es nur einen, also "#1". Übergeben wird hier ein String, also brauchen wir eine Umwandlung in einen numerischen Wert, um den Vergleich "> 0" durchführen zu können.

Parameter-Übergabe und -Prüfung wären damit erledigt, bevor wir uns nun um die Aktionen kümmern, die an "T" und "F" anknüpfen, schauen wir uns noch eine weitere Datenübergabe an unser Makro an, denn neben dem zu prüfenden Wert müssen natürlich noch die Daten übergeben werden, die (falls der Workflow denn Datensätze liefert) in die Output-Datei geschrieben werden sollen.

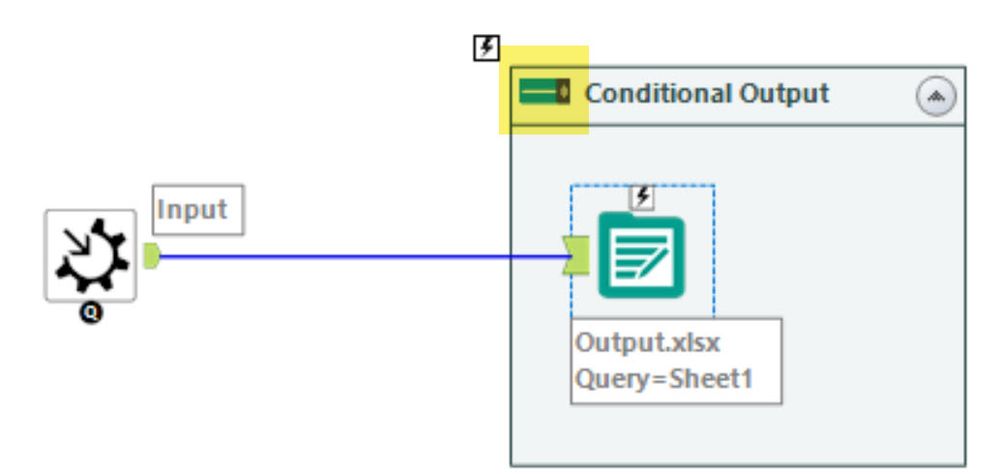

Diese Übergabe kann einfach über ein Macro Input Tool erfolgen. Dieses Tool wird dann mit dem Output Data Tool verbunden, über das dann die Daten in die Ergebnisdatei geschrieben werden. Das Macro Input Tool bekommt den Input Namen "Data" und das Kürzel (Anchor Abbreviation) "D".

Das Output Data Tool soll aber nicht immer aktiv sein, sondern nur, wenn die Bedingung erfüllt ist, es muss sich also ein- und ausschalten lassen. Dazu verwenden wir nun einen kleinen Trick - wir packen das Output Data Tool in einen Tool Container.

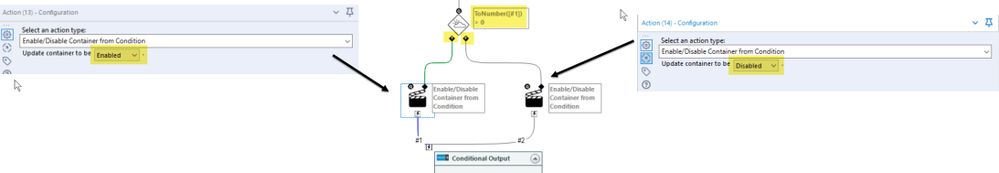

Der Tool Container hat nämlich einen Schalter, über den wir ihn (und alle enthaltenen Tools) aktivieren oder deaktivieren können (enable/disable). Wenn es keine Ergebnisdatensätze gibt, wird also einfach der Tool Container deaktiviert, im anderen Fall soll er aktiv bleiben. Und genau das lösen wir jetzt über zwei Action Tools, die wir zwischen die "T"/"F" Ausgänge des Condition Tools und den Tool Container schalten.

Für beide Action Tools wählen wir den Action Type "Enable/Disable Container from Condition". Bei dem Action Tool, das an den "T"-Ausgang angeschlossen wird, ist die Eigenschaft "Enabled", am "F"-Ausgang dagegen "Disabled" - wenn also die Bedingung erfüllt ist, wird der Tool Container aktiviert, falls aber die Bedingung nicht erfüllt ist, wird er deaktiviert und das Output Data Tool schreibt nicht in die Ergebnis-Datei.

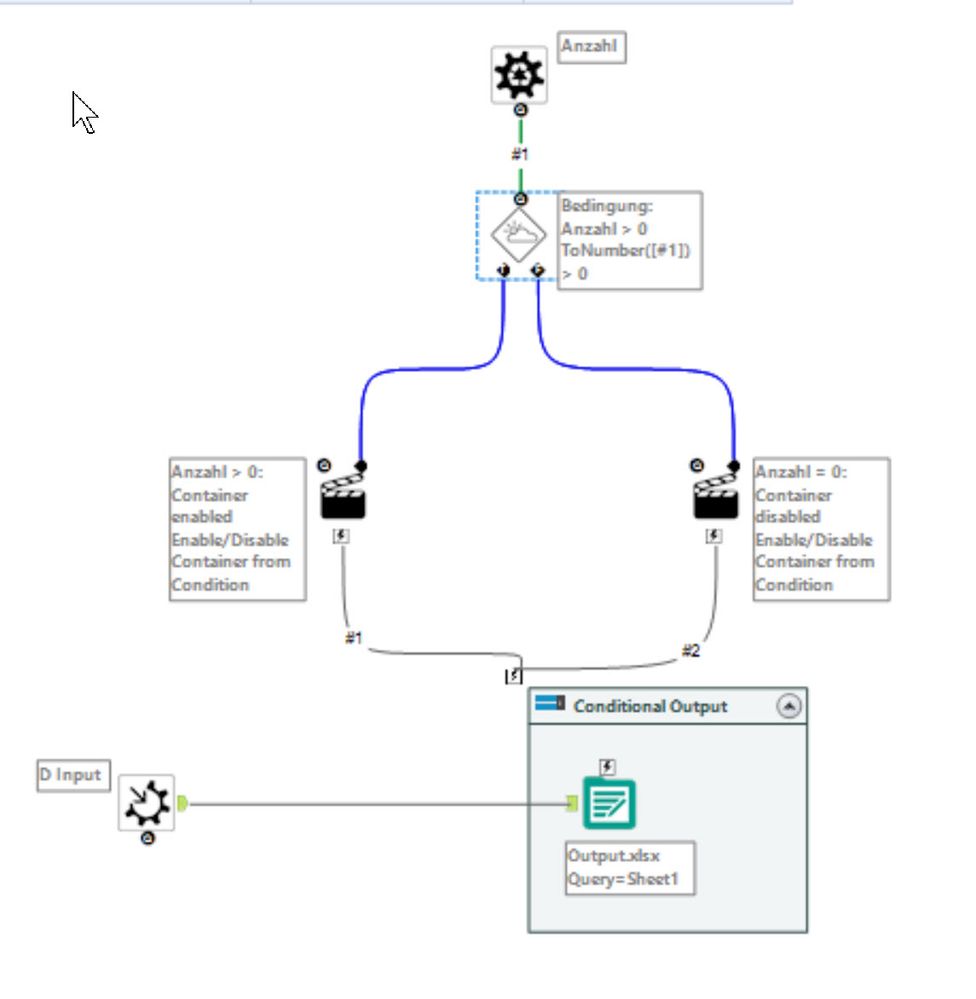

Im Überblck sieht unser Makro so aus:

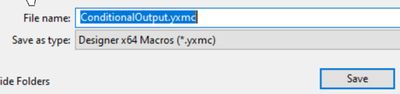

Durch das Control Parameter Tool ist übrigens der Workflow Type automatisch auf "Batch Macro" eingestellt. Eine weitere Konfiguration brauchen wir nicht, aber wir könnten natürlich über den Interface Designer ein eigenes Icon für unser Makro wählen. In jedem Fall speichern wir unser Makro jetzt, wir können es zum Beispiel "ConditionalOutput" nennen, der Dateityp ist bei einem Makro "yxmc".

Bleibt nun nur noch, das Makro in unseren Workflow einzubinden. Zunächst ergänzen wir noch ein Count Records Tool, um die Datensätze zu zählen. Das vorhandene Output Data Tool können wir entfernen, stattdessen fügen wir unser Makro ein. Den "D" Input Anchor verbinden wir mit dem Summarize Tool (da kommen die Datensätze her, die geschrieben werden, wenn es welche gibt).

Den Question Anchor verbinden wir mit dem Count Records Tool, das die zu prüfende Bedingung liefert. In der Konfiguration ist jetzt noch anzugeben, dass Count (also der Output des Count Records Tools) den Parameter Anzahl liefert, ein "Group By" Feld gibt es hier nicht.

Unser Workflow sieht jetzt so aus:

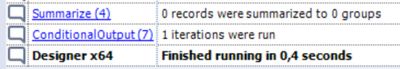

Zeit für einen kleinen Test. Was passiert, wenn die Tabelle "Zuordnung zu P&L Positionen leer ist?

Es gibt keine Meldung mehr, dass in eine Datei geschrieben wird - die vorhandene Datei/Tabelle bleibt intakt, das Makro funktioniert wie wir uns das vorgestellt haben.

Bisher ist das Makro noch sehr spezifisch auf den konkreten Fall abgestimmt, aber es lässt sich natürlich leicht erweitern - so könnten wir etwa den Namen und Typ der Datei als weitere Parameter übergeben. Auch eine flexiblere Steuerung der Bedingung lässt sich leicht umsetzen.

Weitere Tipps Tuesday Beiträge

Dieser Eintrag ist Teil der Tipps Tuesday-Serie, alle Einträge dieser Serie findest du in unserem Index aufgelistet.

Sie müssen ein registrierter Benutzer sein, um hier einen Kommentar hinzuzufügen. Wenn Sie sich bereits registriert haben, melden Sie sich bitte an. Wenn Sie sich noch nicht registriert haben, führen Sie bitte eine Registrierung durch und melden Sie sich an.

-

2019.1 Neue Funktionen

1 -

2019.4

1 -

2019.4 Release

1 -

2020

1 -

2020.1

2 -

2020.2

2 -

2020.3

2 -

2020.4

1 -

2021.1

2 -

2021.4

1 -

2022.1

1 -

2022.3

1 -

2023.1

1 -

2024.1

1 -

ACE

14 -

ACE Programm

1 -

ACE's Insight

1 -

ACEs Insight

1 -

ADAPT

2 -

Agenda

8 -

Algorithmen

1 -

ALTER.NEXT

1 -

AlterNext

1 -

Alteryx Designer

2 -

Alteryx intelligence suite

1 -

Alteryx Excellence Awards

1 -

AMP-Engine

1 -

Amplify.Automation

1 -

analyse

3 -

Analysemodell

1 -

Analysen

1 -

Analytics

3 -

Analytics-Anbieter

1 -

Analytik

1 -

APA

2 -

App

1 -

App Challenge

1 -

Arrange Tool

1 -

Ausgabedaten

1 -

Auswählen

1 -

Auto Insights

1 -

automatisierung

1 -

AUTOREN

1 -

badge

1 -

Banken

1 -

Benachrichtigung

1 -

Best Practices

1 -

beta

1 -

BIG DATA EUROPE

1 -

browse tool

1 -

Business Services

1 -

cfo

3 -

Challenge

1 -

citizen data scientist

2 -

Cloud

1 -

Code Mode

1 -

Computer Vision

1 -

Connections

1 -

Correlation

1 -

COVID-19

5 -

Customer Advocacy

1 -

Data Connection

1 -

Data Festival

1 -

Data Investigation

2 -

Data Preparation

1 -

Data Profiling

2 -

Data Science Portal

1 -

Data Women Zürich

1 -

Date Time

1 -

Daten-Banken

1 -

Datenanalyse

6 -

DATENKULTUR

2 -

Datentypen

1 -

Datenwissenschaft

1 -

DateTime Functions

4 -

DateTime Tool

2 -

DatetimeFormat

1 -

Datum Uhrzeit

1 -

Dean Stoecker

1 -

Decade

1 -

Designer

2 -

digitale Transformation

3 -

Digitalisierung

1 -

Documentation

1 -

Dokumentation

2 -

Drag-and-Drop-Paradigmas

1 -

Dynamische Eingabe

1 -

Eingabedaten

1 -

Einmalig

1 -

Erfolgsfaktor

1 -

Event

4 -

Events

3 -

EVENTS AGENDA

1 -

Excel

3 -

Fachtagung

1 -

feature engineering

1 -

Felderanhängen

1 -

Filter

1 -

Finanzabteilung

4 -

finanzwesen

1 -

Find Replace

1 -

Formel

1 -

Formula

1 -

Formula Tool

1 -

FP&A

1 -

Fuzzy Übereinstimmung

1 -

Gallery

1 -

Gesundheitswesen

1 -

Grand Prix

2 -

Herunterladen

1 -

Hub 20.4

1 -

Hyper-API

1 -

In Database

1 -

In-DB

1 -

Index

1 -

Innovator

1 -

Input-Tools

1 -

inspiration

1 -

Inspire

2 -

Intelligence Suite

4 -

Interface

1 -

Jahrzehnt

1 -

Join

1 -

Kreuztabellen

1 -

Krisen

1 -

kultur de datenanalyse

1 -

Kundendaten

1 -

Kurzarbeitergeld

1 -

Legende

1 -

Lieferketten

1 -

LIVE webinar

1 -

location

1 -

Low-Code-Tools

1 -

Machine Learning

2 -

Macro

1 -

Make Columns

2 -

Malaria

1 -

Modell

1 -

Modellerstellung

1 -

Mongo Atlas

1 -

Multi-Row Formula

1 -

News

1 -

On-demand

2 -

On-demand webinar

1 -

On-Demand-Webinar

1 -

Output Data

1 -

OVERSAMPLE

1 -

Performance

2 -

Platform

1 -

Plattform

1 -

Podcast

2 -

Predictive Analytics

1 -

preview

1 -

Produkt

1 -

Profitabilität

1 -

Programmierkenntnisse

2 -

Python

1 -

Release 2020.1

1 -

release 2021.3

1 -

Reporting

6 -

Reporting in Designer

1 -

reporting tools

1 -

Retail

1 -

Roland Schubert

1 -

Round Up

1 -

rpa

1 -

Running Total

2 -

Santalytics

1 -

Self Service Analytics

1 -

Settings

1 -

Snowflake

2 -

SOMMER

1 -

sort

1 -

Sortierung

2 -

Spatial

2 -

Sprachumschaltung

1 -

Steueranalyse

1 -

Stichproben

1 -

Suchen Ersetzen

1 -

Supply Chain

2 -

Swiss

1 -

Switzerland

1 -

table

1 -

Tableau

1 -

Tax Processes

1 -

Text in Spalten aufteilen

1 -

Texteingabe

1 -

tipps & tricks

2 -

Tipps Tuesday

25 -

Tipps Tuesdays

37 -

Tipps und Tricks

19 -

Tom Becker

1 -

Tool Mastery Serie

1 -

Tool-Palette

1 -

Tools

2 -

Top Autoren

9 -

TOP AUTOREN 2021

1 -

TOP AUTOREN 2022

1 -

Top Contributors

1 -

Tuesday Tipps

16 -

Umstellung

1 -

Union

1 -

User Group

2 -

Virtual Solution Center

1 -

Virtual Solutions Center

1 -

Webinar

6 -

Webinare

1 -

webinars

1 -

Workflow

2 -

You.Vision

2 -

Zusammenfassen

1 -

Zusammenführung

1

- « Vorherige

- Nächste »

| Betreff | Kudos |

|---|---|

| 1 |

-

grossal auf: Meldung Tool | Tipps Tuesdays #095

-

grossal auf: Alle Output-Tools deaktivieren | Tipps Tuesdays #0...

- Buzz auf: Mehrere Daten mit einem Tool einlesen - Wildcards ...

- Buzz auf: Kommentare in Formeln | Tipps Tuesdays #018

- Buzz auf: Was bedeutet es ein Innovator zu sein? Ein Blick h...

- MWoelfels auf: Prefix / Suffix hinzufügen oder entfernen | Tipps ...

- ASTX auf: Datentypen ändern | Tipps Tuesday #014

-

RolandSchubert auf: Tool Container: Tools im Workflow organisieren - u...

- StephV auf: Alteryx Excellence Awards 2021

- LeahK auf: TOP AUTOREN 2020