Blog - Deutsch

Erkenntnisse und Ideen von den besten Analytics-Experten.- RSS-Feed abonnieren

- Als neu kennzeichnen

- Als gelesen kennzeichnen

- Lesezeichen

- Abonnieren

- Drucker-Anzeigeseite

- Moderator informieren

- RSS-Feed abonnieren

- Als neu kennzeichnen

- Als gelesen kennzeichnen

- Lesezeichen

- Abonnieren

- Drucker-Anzeigeseite

- Moderator informieren

Natürlich nutzt jeder gern die Tools, die er kennt, das ist bei mir nicht anders. Auch wenn es vielleicht Lösungen gibt, die eleganter oder technisch anspruchsvoller sein mögen, ohne einen konkreten Vorteil bleibe ich meistens bei den bewährten Ansätzen.

Bei den In-Database-Tools gibt es aber Anwendungsfälle, in denen sie einen echten Vorteil bieten. Um welchen Vorteil es hier geht und wie man die entsprechenden Fälle identifizert soll heute unser Thema sein.

Den Vorteil kann man sehr klar benennen: Performance! Mit In-Database kann man Workflows deutlich beschleunigen - und zumindest bei mir hat sich noch nie jemand beschwert, weil ein Workflow zu schnell ist.

Der Unterschied lässt sich an einem kleinen Bespiel leicht zeigen. Nehmen wir einmal an, wir möchten die Ergebnisse einer Werbekampagne messen. Zu diesem Zweck haben wir eine Excel-Tabelle mit den beworbenen Produkten (etwa 50 von insgesamt 1000) und eine zweite Excel-Tabelle mit dem Aktionszeitraum (5 Tage). Außerdem haben wir eine Datenbanktabelle mit den Transaktionen eines Jahres (ca. 30 Millionen Datensätze).

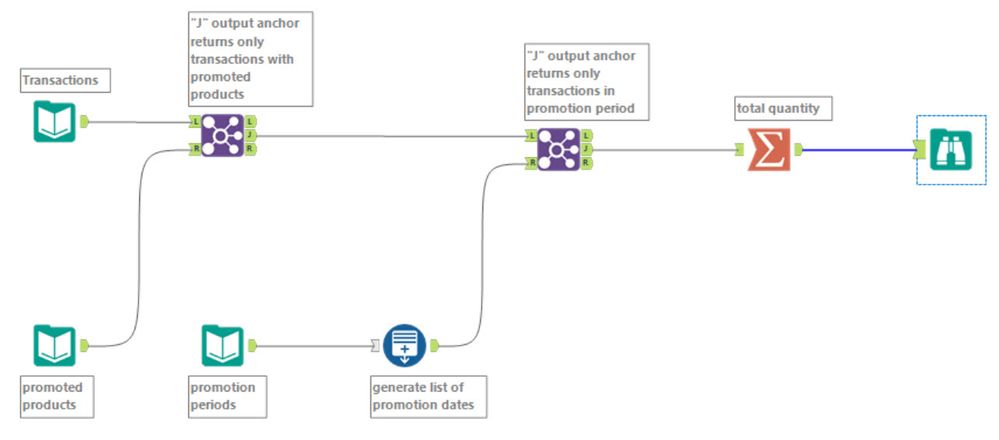

Ein Lösungsansatz könnte sein, die Transaktionsdaten und die Produkte über jeweils ein Input Data Tool zu laden und ein Join-Tool zu verwenden, um die beworbenen Produkte zu selektieren (der "J" Output Anchor liefert nur die Produkte, die in der Excel-Datei enthalten sind). Den Werbezeitraum laden wir über ein weiteres Input Data Tool, erzeugen mit dem Generate Rows Tool eine Zeile mit dem entsprechenden Datum und wählen wiederum über ein Join Tool die Datensätze aus, die in den Werbezeitraum fallen. Dann können wir noch summieren - fertig. Insgesamt sieht das so aus:

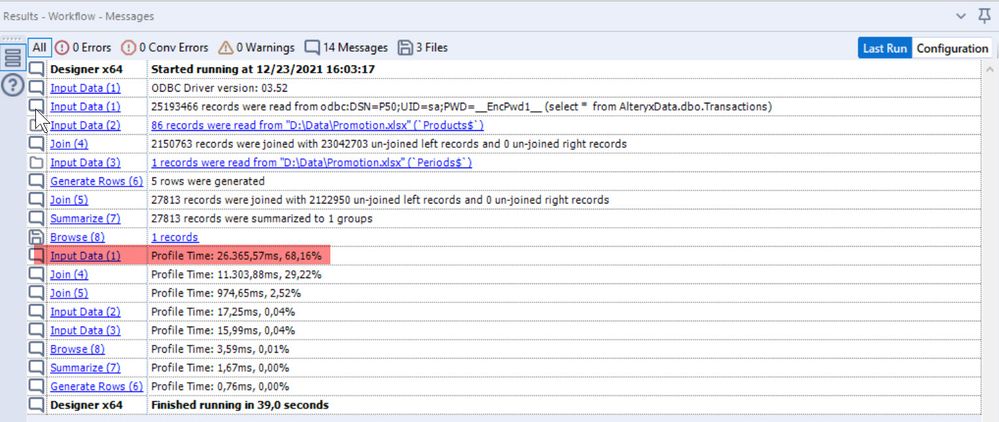

Wenn wir diesen Workflow ausführen, haben wir nach knapp 40 Sekunden ein Ergebnis - für 30 Millionen Datensätze eigentlich nicht schlecht. Aber schauen wir uns mal an, wo die Zeit verbraucht wird:

Klare Sache: Bei der Abfrage der Transaktionsdaten, schließlich werden hier 30 Millionen Datensätze in Alteryx gezogen. Anzumerken ist noch, dass bei diesem Test keine Verzögerung durch Netzwerk oder Serverbelastung auftrat - in der Realität ist der Anteil also eher höher.

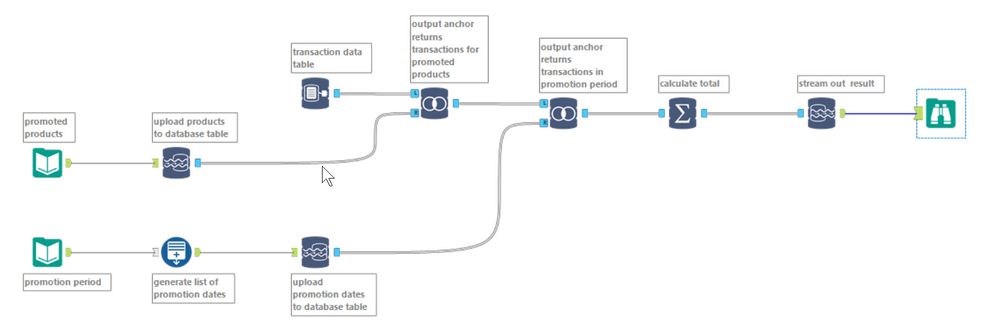

Genau hier können die In-Database Tools helfen. Unser größtes Problem ist, dass wir eine große Anzahl von Datensätzen vom Server in Alteryx laden, um dort zwei Joins mit sehr kleinen Anzahlen von Datensätzen eauszuführen, Mit In-DB kehren wir das einfach um. Wir ziehen nicht die große Zahl Datensätze von der Datenbank in Alteryx, sondern wir schieben die kleinen Tabellen in die Datenbank und führen die Join-Operationen dort durch.

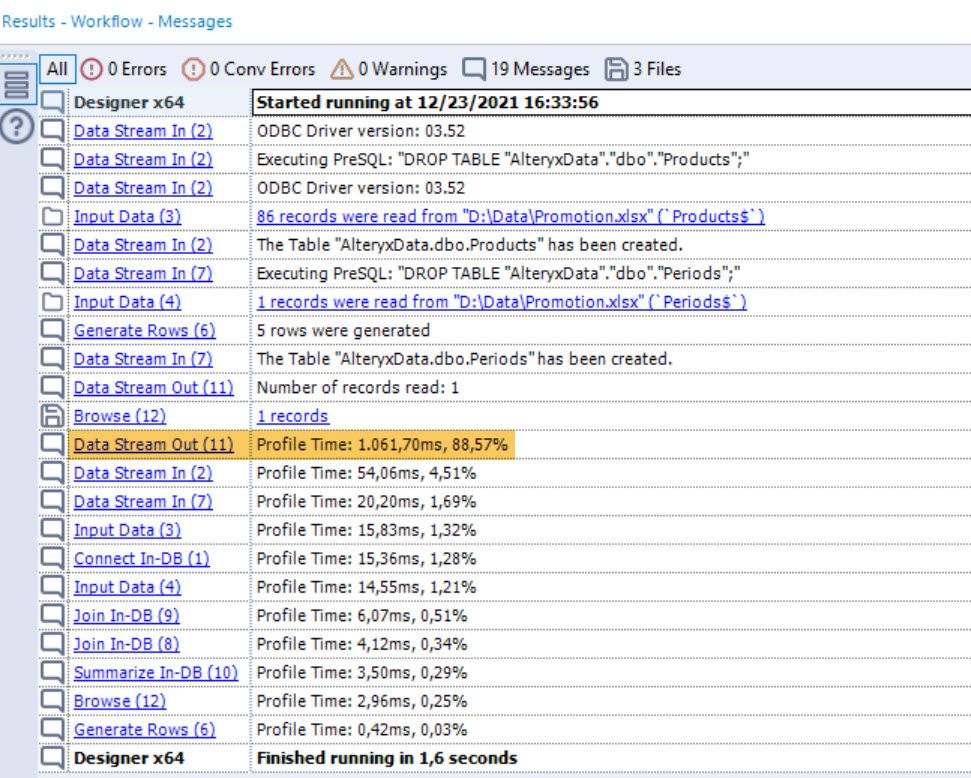

Wieder gibt es ein Tool, dass den Großteil der Zeit verbraucht - diesmal ist es das Data Stream Out Tool. Allerdings ist ein Großteil hier etwas mehr als eine Sekunde, insgesamt benötigt der Workflow knapp 2 Sekunden. Mal eben Faktor 20!!!

Hier hat es sich also gelohnt, In-Database Tools zu nutzen. Lassen sich daraus allgemeine Regeln ableiten, in welchen Fällen man den Anstz in Erwägung ziehen sollte?

Generell gilt - wenn eine sehr große Anzahl Datensätze von einem SQL-Server gezogen wird, um mit einer kleinen Anzahl von Datensätzen, die lokal vorliegen, verknüpft zu werden, und das Ergebnis nur noch einen kleinen Teil der SQL-Tabelle enthält, sollte man darüber nachdenken (wenn von den 30 Millionen Datensätzen am Ende noch 29 Milliuonen übrigbleiben, lohnt es sich vielleicht eher nicht - der Data Stream Out wird dann die eingesparte Zeit verbrauchen.

Auch wenn alle Tabellen schon auf dem SQL-Server liegen, kann In-DB eine sinnvolle Lösung sein. Klar, das entsprechende SQL-Statement könnte man auch direkt in ein Input Data Tool schreiben - aber eben auch über In-Database Tools abbilden. Und dann sieht man direkt, was passiert, so wie man es von Alteryx gewohnt ist.

Weitere Tipps Tuesday Beiträge

Dieser Eintrag ist Teil der Tipps Tuesday-Serie, alle Einträge dieser Serie findest du in unserem Index aufgelistet.

Sie müssen ein registrierter Benutzer sein, um hier einen Kommentar hinzuzufügen. Wenn Sie sich bereits registriert haben, melden Sie sich bitte an. Wenn Sie sich noch nicht registriert haben, führen Sie bitte eine Registrierung durch und melden Sie sich an.

-

2019.1 Neue Funktionen

1 -

2019.4

1 -

2019.4 Release

1 -

2020

1 -

2020.1

2 -

2020.2

2 -

2020.3

2 -

2020.4

1 -

2021.1

2 -

2021.4

1 -

2022.1

1 -

2022.3

1 -

2023.1

1 -

2024.1

1 -

ACE

14 -

ACE Programm

1 -

ACE's Insight

1 -

ACEs Insight

1 -

ADAPT

2 -

Agenda

8 -

Algorithmen

1 -

ALTER.NEXT

1 -

AlterNext

1 -

Alteryx Designer

2 -

Alteryx intelligence suite

1 -

Alteryx Excellence Awards

1 -

AMP-Engine

1 -

Amplify.Automation

1 -

analyse

3 -

Analysemodell

1 -

Analysen

1 -

Analytics

3 -

Analytics-Anbieter

1 -

Analytik

1 -

APA

2 -

App

1 -

App Challenge

1 -

Arrange Tool

1 -

Ausgabedaten

1 -

Auswählen

1 -

Auto Insights

1 -

automatisierung

1 -

AUTOREN

1 -

badge

1 -

Banken

1 -

Benachrichtigung

1 -

Best Practices

1 -

beta

1 -

BIG DATA EUROPE

1 -

browse tool

1 -

Business Services

1 -

cfo

3 -

Challenge

1 -

citizen data scientist

2 -

Cloud

1 -

Code Mode

1 -

Computer Vision

1 -

Connections

1 -

Correlation

1 -

COVID-19

5 -

Customer Advocacy

1 -

Data Connection

1 -

Data Festival

1 -

Data Investigation

2 -

Data Preparation

1 -

Data Profiling

2 -

Data Science Portal

1 -

Data Women Zürich

1 -

Date Time

1 -

Daten-Banken

1 -

Datenanalyse

6 -

DATENKULTUR

2 -

Datentypen

1 -

Datenwissenschaft

1 -

DateTime Functions

4 -

DateTime Tool

2 -

DatetimeFormat

1 -

Datum Uhrzeit

1 -

Dean Stoecker

1 -

Decade

1 -

Designer

2 -

digitale Transformation

3 -

Digitalisierung

1 -

Documentation

1 -

Dokumentation

2 -

Drag-and-Drop-Paradigmas

1 -

Dynamische Eingabe

1 -

Eingabedaten

1 -

Einmalig

1 -

Erfolgsfaktor

1 -

Event

4 -

Events

3 -

EVENTS AGENDA

1 -

Excel

3 -

Fachtagung

1 -

feature engineering

1 -

Felderanhängen

1 -

Filter

1 -

Finanzabteilung

4 -

finanzwesen

1 -

Find Replace

1 -

Formel

1 -

Formula

1 -

Formula Tool

1 -

FP&A

1 -

Fuzzy Übereinstimmung

1 -

Gallery

1 -

Gesundheitswesen

1 -

Grand Prix

2 -

Herunterladen

1 -

Hub 20.4

1 -

Hyper-API

1 -

In Database

1 -

In-DB

1 -

Index

1 -

Innovator

1 -

Input-Tools

1 -

inspiration

1 -

Inspire

2 -

Intelligence Suite

4 -

Interface

1 -

Jahrzehnt

1 -

Join

1 -

Kreuztabellen

1 -

Krisen

1 -

kultur de datenanalyse

1 -

Kundendaten

1 -

Kurzarbeitergeld

1 -

Legende

1 -

Lieferketten

1 -

LIVE webinar

1 -

location

1 -

Low-Code-Tools

1 -

Machine Learning

2 -

Macro

1 -

Make Columns

2 -

Malaria

1 -

Modell

1 -

Modellerstellung

1 -

Mongo Atlas

1 -

Multi-Row Formula

1 -

News

1 -

On-demand

2 -

On-demand webinar

1 -

On-Demand-Webinar

1 -

Output Data

1 -

OVERSAMPLE

1 -

Performance

2 -

Platform

1 -

Plattform

1 -

Podcast

2 -

Predictive Analytics

1 -

preview

1 -

Produkt

1 -

Profitabilität

1 -

Programmierkenntnisse

2 -

Python

1 -

Release 2020.1

1 -

release 2021.3

1 -

Reporting

6 -

Reporting in Designer

1 -

reporting tools

1 -

Retail

1 -

Roland Schubert

1 -

Round Up

1 -

rpa

1 -

Running Total

2 -

Santalytics

1 -

Self Service Analytics

1 -

Settings

1 -

Snowflake

2 -

SOMMER

1 -

sort

1 -

Sortierung

2 -

Spatial

2 -

Sprachumschaltung

1 -

Steueranalyse

1 -

Stichproben

1 -

Suchen Ersetzen

1 -

Supply Chain

2 -

Swiss

1 -

Switzerland

1 -

table

1 -

Tableau

1 -

Tax Processes

1 -

Text in Spalten aufteilen

1 -

Texteingabe

1 -

tipps & tricks

2 -

Tipps Tuesday

25 -

Tipps Tuesdays

37 -

Tipps und Tricks

19 -

Tom Becker

1 -

Tool Mastery Serie

1 -

Tool-Palette

1 -

Tools

2 -

Top Autoren

9 -

TOP AUTOREN 2021

1 -

TOP AUTOREN 2022

1 -

Top Contributors

1 -

Tuesday Tipps

16 -

Umstellung

1 -

Union

1 -

User Group

2 -

Virtual Solution Center

1 -

Virtual Solutions Center

1 -

Webinar

6 -

Webinare

1 -

webinars

1 -

Workflow

2 -

You.Vision

2 -

Zusammenfassen

1 -

Zusammenführung

1

- « Vorherige

- Nächste »

-

grossal auf: Meldung Tool | Tipps Tuesdays #095

-

grossal auf: Alle Output-Tools deaktivieren | Tipps Tuesdays #0...

- Buzz auf: Mehrere Daten mit einem Tool einlesen - Wildcards ...

- Buzz auf: Kommentare in Formeln | Tipps Tuesdays #018

- Buzz auf: Was bedeutet es ein Innovator zu sein? Ein Blick h...

- MWoelfels auf: Prefix / Suffix hinzufügen oder entfernen | Tipps ...

- ASTX auf: Datentypen ändern | Tipps Tuesday #014

-

RolandSchubert auf: Tool Container: Tools im Workflow organisieren - u...

- StephV auf: Alteryx Excellence Awards 2021

- LeahK auf: TOP AUTOREN 2020