Base de Connaissance

Apprenez auprès des experts.TIPS de la semaine

Chaque semaine, découvrez de nouvelles astuces et bonnes pratiques pour devenir un expert !

Voir l'index- Community

- :

- Communauté

- :

- Apprendre

- :

- Base de Connaissance

- :

- Grattage Web

Grattage Web

- S'abonner au fil RSS

- Marquer comme nouveau

- Marquer comme lu

- Marquer

- S'abonner

- Page imprimable

- Signaler au modérateur

11-05-2018 08:08 PM - modifié 03-05-2019 10:55 AM

Grattage Web, le processus d'extraction de l'information (généralement en tableaux) à partir de sites Web, est une approche extrêmement utile pour recueillir encore des données hébergées sur le Web qui n'est pas fourni via les API. Dans de nombreux cas, si les données que vous recherchez sont autonomes ou capturées complètement sur une page (pas besoin de requêtes API dynamiques), il est encore plus rapide que le développement de connexions API directes à collecter.

Avec la richesse des données déjà fournies sur des sites Web, l'accès facile à ces données peut être un grand supplément à vos analyses pour fournir le contexte ou juste fournir les données sous-jacentes pour poser de nouvelles questions. Bien qu'il existe une poignée d'approches de grattage Web (deux détaillées sur notre communauté, ici et ici), il ya un certain nombre de grands, libres, outils (parsehub et import.IO pour n'en nommer que quelques-uns) en ligne qui peut rationaliser vos efforts de grattage Web. Cet article détaille une approche que je trouve être particulièrement facile, en utilisant Import.IO pour créer un extracteur spécifique à vos sites Web désirés, et l'intégration des appels à eux dans votre flux de travail via un lien API de requête en direct qu'ils fournissent par le biais du service. Vous pouvez le faire en quelques étapes rapides:

1. Accédez à leur page d'accueil, https://www.Import.IO/, et «inscrivez-vous» dans le coin supérieur droit:

2. Une fois que vous êtes inscrit à l'utilisation du service, accédez à votre tableau de bord (un lien peut être trouvé dans le même coin de la page d'accueil une fois connecté) pour gérer vos extracteurs.

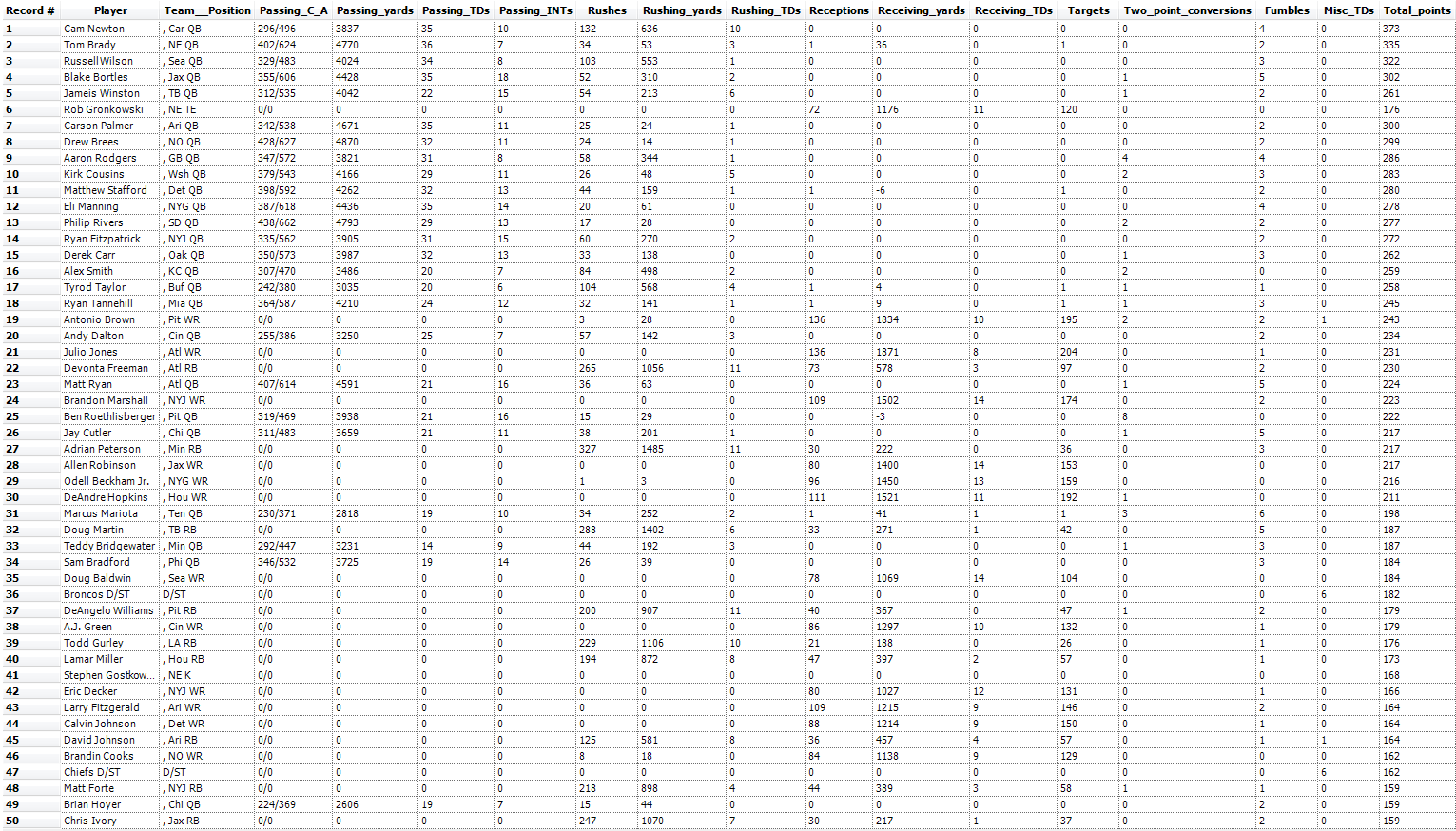

3. Cliquez sur "nouvel extracteur" dans le coin supérieur gauche et collez l'URL qui contient les données que vous essayez de gratter dans le "créer Extractor" pop up. Depuis la saison de dessin fantasy football est juste devant nous, nous allons aller de l'avant et l'utilisation comme un exemple de données compilées par les meilleurs buteurs de l'année dernière fourni par ESPN afin que vous ne finissent pas comme ce gars-là (Merci plus tard). Nous savons que nos utilisateurs vont dur et les enjeux sont probablement assez élevés, nous voulons donc vouloir obtenir ce droit la première fois, et en utilisant une approche qui est assez reproductible pour nous fournir les informations nécessaires pour nous garder parmi les équipes de haut chaque année.

4. Après quelques instants, import.IO aura gratté toutes les données de la page Web et vous l'affichera dans leur «vue de données». Ici, vous pouvez ajouter, supprimer ou renommer des colonnes dans la table en sélectionnant des éléments sur la page Web – il s'agit d'une étape facultative qui peut vous aider à affiner votre dataset avant de générer votre URL de requête Live API pour le transfert, vous pouvez tout aussi facilement effectuer la plupart de ces opérations dans t Il designer. Pour mon exemple, j'ai renommé les colonnes pour refléter les noms de statistiques sur ESPN et a ajouté le "misc TD" champ qui a échappé à l'algorithme de grattage.

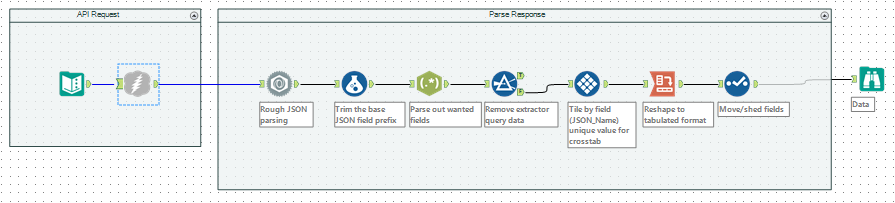

5. Une fois que vos données sont prêtes à l'importation, cliquez sur le bouton rouge "Done" dans le coin supérieur droit. Vous serez redirigé vers votre tableau de bord où vous pouvez maintenant voir l'extracteur que vous avez créé dans la dernière étape-Sélectionnez cet extracteur et recherchez la pièce de puzzle "intégrer" l'onglet juste au-dessous du nom de l'extracteur dans votre vue. Vous pouvez copier et coller l'"API de requête en direct" (il ya aussi une option pour télécharger un fichier CSV de vos données) énumérés ici dans une fenêtre de navigateur pour copier la réponse JSON qui contient vos données, ou vous pouvez mettre en œuvre un appel à elle directement dans votre workflow en utilisant l'outil de téléchargement (n'oubliez pas de sélectionner "coder l'URL" comme vous spécifiez le champ URL):

Voilà! Vous devez maintenant avoir une API de requête en direct intégrée pour votre page Web, et avec un extracteur qui peut être exploité pour ratisser des données à partir de ce site si vous voulez essayer d'autres pages ainsi. Si vous souhaitez en savoir plus sur l'approche, ou sur la façon de le personnaliser avec des scripts externes, essayez la communauté Import.IO. L'échantillon que j'ai utilisé ci-dessus est attaché ici dans la version 10.5 de workflow yxmd, il vous suffit de mettre à jour l'API de requête en direct avec un spécifique à votre compte, extracteur et URL de page Web. Si vous décidez de lui donner un essai avec l'exemple ci-dessus, soyez sûr de nous faire savoir si nous avons aidé votre équipe fantastique gagner gros!

-

0

13 -

1

7 -

10

22 -

11

7 -

11.3

1 -

2018.3

1 -

5

11 -

6

2 -

Academy

1 -

ACE

1 -

ACE's Insight

3 -

ACE's Insights

2 -

Agréger

1 -

Ajouter des champs

1 -

Allumette floue

1 -

Alteryx Designer

9 -

Analyse géographique

1 -

Analyse normative

1 -

Analyse prédictive

2 -

Analyser

4 -

Analytic Apps & Macros

1 -

API

7 -

App

1 -

Application chaînée

2 -

Applications

1 -

Apps

9 -

Apps et macros

1 -

article

1 -

astuce

1 -

Astuce quotidienne

1 -

astuces

3 -

BASE DE CONNAISSANCE

1 -

Base de connaissances

1 -

blog

1 -

Bloquer

1 -

Cache

2 -

Cas courant

5 -

Cas courants

3 -

Cas d'usage courant

24 -

classement

1 -

Clustering

1 -

Comment

49 -

Comment j'ai relevé le défi

4 -

Communauté

5 -

Compte

1 -

Conditions d'utilisation

1 -

Confidentialité

1 -

Configuration

1 -

Connecteurs

9 -

Connector FTP

1 -

Connectors

1 -

Connexion de base de données

8 -

contribution

2 -

Dans la base de données

1 -

dataprep

1 -

dataviz

1 -

Date

1 -

Date heure

4 -

Date Time

2 -

DateHeure

1 -

dates

1 -

Designer

3 -

Developer

1 -

Documentation

15 -

Données

8 -

débuter

1 -

Défi hebdomadaire

4 -

Défis Hebdomadaires

2 -

Démarrage

1 -

Développeur

2 -

Enquête sur les données

2 -

Entrée

20 -

Entrée de données

1 -

Entrée dynamique

1 -

Explorateur

1 -

Expression

8 -

Exécuter la commande

3 -

Filtrer

1 -

Filtres

1 -

Format de Date

1 -

Formula

2 -

Formula Tool

1 -

Formule

4 -

Formule à plusieurs lignes

2 -

francophone

3 -

FTP

1 -

Fuzzy Matching

1 -

Galerie

9 -

Gallery

1 -

Gestionnaire d'alias

4 -

Google Analytics

2 -

groupe interne d'utilisateurs

1 -

importer

1 -

In Database

1 -

In-DB

1 -

Index

1 -

Informations personnelles

1 -

Installation

8 -

Jointure

4 -

Jour

1 -

JSON

1 -

LDR

1 -

Licences

5 -

Lignes directrices

1 -

Macro

1 -

Macro batch

6 -

Macro dev CS

2 -

Macro itérative

2 -

Macros

9 -

Maitrise de la fonction

2 -

Maîtrise d'Outil

4 -

Maîtrise de l'outil

23 -

Maîtrise de la fonction

3 -

Maîtrise de l’outil

2 -

Meilleures pratiques

18 -

Message d'erreur

5 -

Messagerie

1 -

MongoDB

1 -

Onboarding

1 -

Optimisation

1 -

Outil R

2 -

Outils d'interface

4 -

Outils de développement

4 -

Paramètres

2 -

Parse

2 -

Planificateur

5 -

Plusieurs jointures

1 -

PNL

1 -

Politiques

2 -

position

1 -

Power BI

1 -

Pratiques Exemplaires

1 -

Processus d'accueil

1 -

Processus d'intégration

1 -

Préparation

10 -

publication

1 -

Publier

2 -

Python

2 -

rang

1 -

Rapports

1 -

Rechercher et remplacer

1 -

Regex

2 -

Rejoindre

3 -

Réglementaire

1 -

Saisie de texte

1 -

Salesforce

2 -

SDK

1 -

Self Service Analytics

1 -

Server

1 -

serveur

1 -

SFTP

1 -

Sortie

12 -

Sortie de données

1 -

Spatial Analysis

1 -

Spatial Coverage

1 -

SRB.

1 -

Sélectionner

1 -

Tableau

1 -

Telco

1 -

test

1 -

Texte en colonnes

1 -

Tip du jour

1 -

Tips

1 -

Tool Mastery

2 -

Traitement dynamique

5 -

Transformation

1 -

Transposer

1 -

Traçabilité

1 -

Trier

1 -

Trucs et astuces

36 -

Télécharger

7 -

Union

1 -

Unique

1 -

User Group

1 -

utilisateurs

1 -

WinScp

1 -

Workflow

27 -

À

2 -

Échantillon

1

- « Précédent

- Suivant »