Blog

Visiones e ideas de las mentes más brillantes en el campo del análisis.- Suscribirse a un feed RSS

- Marcar como nuevo

- Marcar como leída

- Favorito

- Suscribir

- Página de impresión sencilla

- Notificar al moderador

- Suscribirse a un feed RSS

- Marcar como nuevo

- Marcar como leída

- Favorito

- Suscribir

- Página de impresión sencilla

- Notificar al moderador

Bloques analíticos para Procesamiento de Lenguaje Natural

Identificación de tópicos

Esos son muchos datos sin estructura, pero no te preocupes.

Cuando te das cuenta de la amplitud y variedad de posibilidades que Alteryx te ofrece con la Minería de Texto.

Los siguientes 3 bloques analíticos tienen que ver más con el tema de procesamiento de lenguaje natural (NLP).

El primero que revisaremos será el proceso de identificación de tópicos para el que utilizaremos 3 bloques analíticos:

- Preprocesamiento de textos

- Modelado de tópicos

- Nube de palabras

Modelado de tópicos

Es un tipo de modelo estadístico que barre documentos e identifica patrones de uso de palabras y las agrupa en temas. Los modelos de tópicos ayudan a organizar y ofrecen información para comprender una gran colección de texto no estructurado, ayuda a los analistas a dar sentido a las colecciones de documentos (conocidos como corpus en el mundo del procesamiento de lenguaje natual) identificando temas y organizando los textos en grupos.

Para llevarlo a cabo el primer paso es:

Limpieza de datos previa

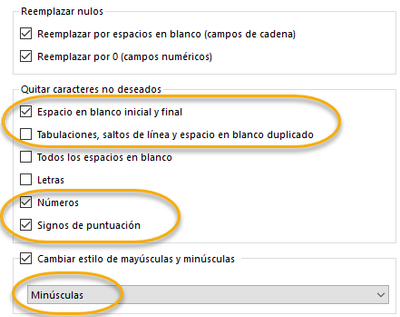

Antes de empezar es buena práctica hacer una limpieza del texto usando el bloque analítico de Limpieza de datos para eliminar los espacios en blanco al principio y al final, los números, signos de puntuación y cambiar todo el texto a minúsculas.

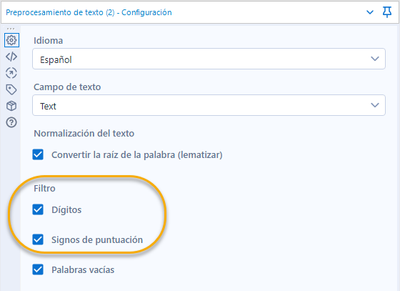

Preprocesamiento de texto

Este bloque analítico nos presenta varias opciones para preparar los datos antes de hacer la identificación de tópicos.

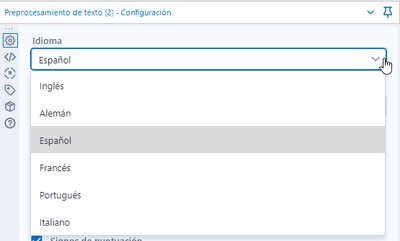

El primer paso es escoger el idioma entre:

- Inglés

- Alemán

- Español

- Francés

- Portugués

- Italiano

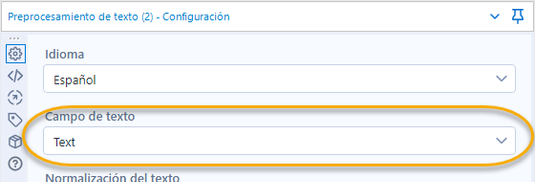

El siguiente es el campo de texto que preprocesaremos.

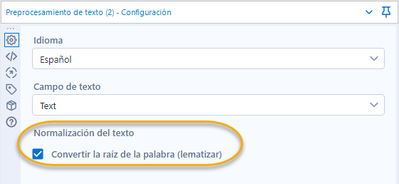

A continuación, seleccionamos si queremos aplicar lematización.

Lematizar

Lematizar es el proceso que estandariza el texto, convierte las palabras a su raíz para facilitar su agrupación y análisis si tenemos, por ejemplo:

Corriendo, corrí, corrimos, corrieron, corran, corramos. Si lematizamos ese verbo, quedaría como correr, en infinitivo.

Tokenización

Otro proceso importante que ocurre en el preprocesamiento es la tokenización, es decir agregarle símbolos individuales a cada componente del texto para poder procesarlo fácilmente.

El proceso tiene que ver con separar cada palabra en una lista de tokens para que el proceso de análisis de texto lo trate como elemento independiente cada palabra.

Posteriormente aplicamos filtros a los dígitos y signos de puntuación.

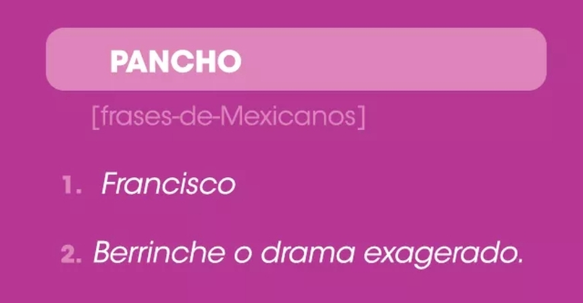

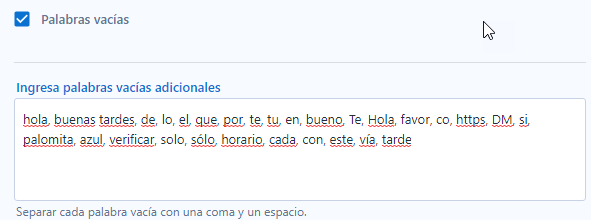

Palabras vacías

El último paso es remover las palabras vacías o stop words.

Son palabras que se filtran antes de procesar el texto para su análisis pero, aunque estás se refieren a las palabras más comunes del lenguaje como las preposiciones y los pronombres que son frecuentes pero no aportan al significado del texto, sólo le aportan validez gramatical, no es posible filtrar todas ni todas las que se remueven necesariamente no tienen utilidad.

Debido a la complejidad del lenguaje, incluso hay palabras que pueden ser útiles como dependiendo del objetivo que se busca.

Si tomamos por ejemplo nombres de películas, podríamos filtrar Eso pero dejaríamos de fuera un título o si quitamos números podríamos dejar de considerar libros como 1984 de George Orwell por citar algunos.

Para eso se utiliza la librería SpaCy. Si una palabra se cuela en tu análisis quiere decir que no está incluida en la lista de palabras vacías de la librería, es ahí donde puedes agregarla manualmente para filtrarla. Si son varias las puedes separar con comas.

Este proceso no dará un nuevo campo con el texto preprocesado y listo para utilizarlo en el modelado de tópicos.

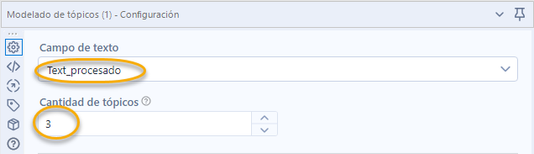

Modelado de tópicos

Para modelar o identificar temas dentro de documentos, utilizamos el algoritmo LDA (Latent Dirichlet Allocation).

Para hacerlo, básicamente crea grupos o clusters de palabras de acuerdo a los patrones de uso de palabras que tienen.

Es muy útil para organizar y aportar hallazgos para la comprensión de grandes cantidades de texto no estructurado y darles sentido a colecciones de documentos, identificando temas y organizando los textos en grupos.

Las opciones de configuración son las siguientes:

Comenzamos seleccionando el campo de texto que procesaremos y el número de tópicos que queremos generar. Típicamente este es un paso que requiere varias iteraciones y un proceso de prueba y error para encontrar el número óptimo de temas de acuerdo al objetivo que estamos buscando.

Requiere un proceso iterativo porque el proceso utiliza un modelo no supervisado y difuso, que hace más fácil comenzar a usarlo ya que no requiere entrenamiento pero que necesita interpretación de los tópicos por parte del usuario.

Opciones de salida.

- Gráfico interactivo

- Resumen de relevancia de palabras

Más adelante las explicaré.

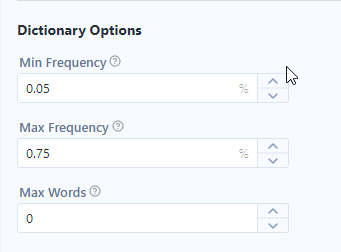

A continuación, tenemos las opciones de diccionario. Aquí podemos escoger las palabras que queremos considerar para nuestro análisis.

- Frecuencia mínima, en la imagen nos quedamos con las palabras que aparecen al menos en el 5% de los documentos

- La frecuencia máxima específica el limite superior para incluir una palabra, en el caso de la imagen sólo consideraremos las que aparezcan en menos del 75% de los documentos

- Máximo de palabras es para limitar la cantidad de palabras que usaremos para el análisis.

La recomendación cuando estamos comenzando es dejar los valores por omisión que tiene el bloque analítico para así obtener el mejor resultado.

Y finalmente las opciones de LDA.

- Alpha: Es la densidad de tópicos dentro de cada documento, si aumentamos el parámetro, reconocerá más tópicos y viceversa.

- Eta: Representa la densidad de palabras que se requieren para crear un tópico, con un mayor valor aumentará la cantidad de palabras necesarias para identificar un tópico.

Aquí también la recomendación es mantener las opciones recomendadas para un resultado óptimo.

Resultados

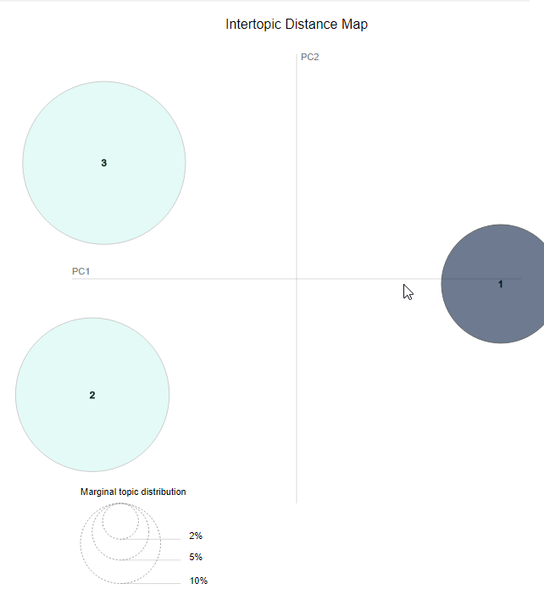

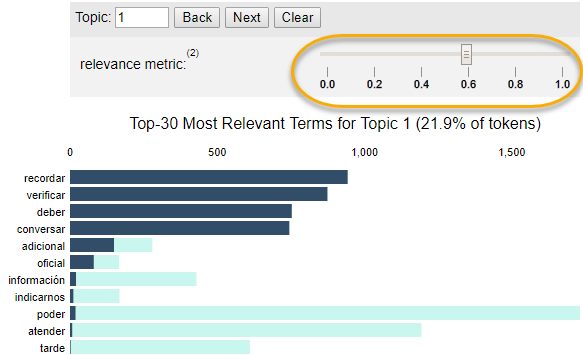

Seleccionando la salida R (resultados), podemos ver el gráfico interactivo con los resultados.

Gráfico interactivo

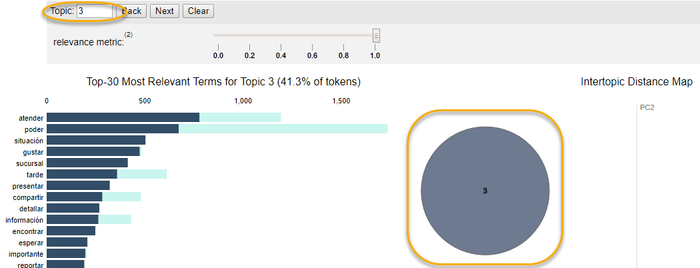

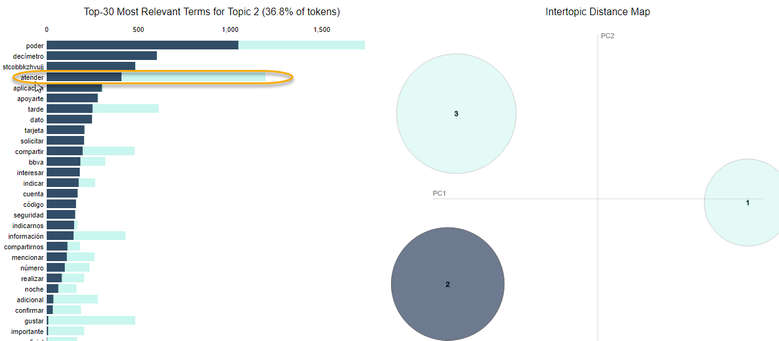

El gráfico interactivo tiene dos partes, un mapa con la distancia entre los tópicos, que nos muestra que tan similares son los temas que se identificaron, podemos ver si hay traslape en algunos términos si son lo suficientemente separados para nuestro análisis.

Eso quiere decir que los tópicos que están más cerca uno de otro, tienen más palabras en común.

Para graficarlo se usa componentes principales para reducir las dimensiones y poder visualizarlo en una gráfica bidimensional.

En la imagen tenemos un mapa con 3 tópicos y podemos ver que están claramente diferenciados entre sí, el tamaño del circulo representa la cantidad de palabras que contiene cada tópico.

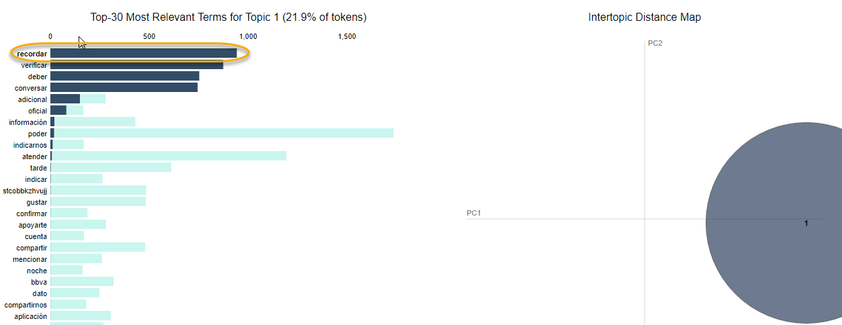

Si seleccionamos un tópico, cambia de color y nos presenta las palabras que contiene en la parte izquierda de la pantalla.

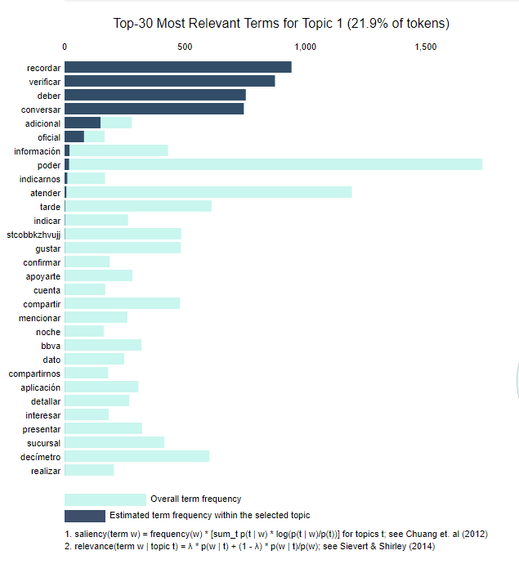

En la parte izquierda del reporte interactivo nos muestra las 30 palabras más relevantes para cada tópico, donde podemos evaluar el contenido de cada tópico y seleccionar las palabras que consideremos más convenientes para asignar como tópico para hacerlo más sencillo de consumir para los usuarios finales.

Las barras indican la qué tanto aparece una palabra dentro del total de documentos.

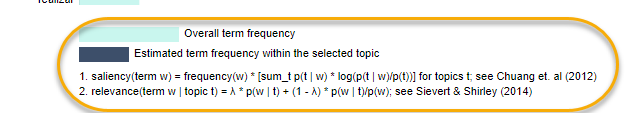

Prominencia (saliency) es una métrica específica que se define al final de la visualización y se puede pensar como la métrica usada para identificar las palabras que sean más informativas o útiles para identificar tópicos. Una prominencia mayor indica que la palabra es más útil para identificar un tópico específico.

Cuando se selecciona un tópico en el mapa de distancia entre temas, o se específica un tópico en el panel superior, la gráfica de barras cambia para mostrar las palabras más prominentes incluidas en el tópico seleccionado.

Una segunda barra más oscura se muestra encima de la frecuencia total de la palabra y muestra la frecuencia específica por tópico de palabras que pertenecen al tópico seleccionado. Si la barra oscura se sobrepone por completo a la barra clara, la palabra pertenece casi exclusivamente al tópico seleccionado.

Cuando se selecciona una palabra en la gráfica de barras, los tópicos y probabilidades por cada tópico de esa palabra se muestran en el mapa de distancia entre tópicos, de esta forma puedes ver qué otros tópicos comparten esa palabra.

Por ejemplo, la palabra atender aparece abajo en los tres temas.

Mientras que la palabra recordar a continuación solo aparece en el tópico 1.

Esto quiere decir que podemos usar las palabras que tienen mayor frecuencia dentro de cada tópico para etiquetarlo, como en caso anterior, el tópico 3 sería Recordar/Verificar.

Si ajustamos la barra con la métrica de relevancia, nos mostrará los términos que sean potencialmente más raros y exclusivos para el tópico seleccionado.

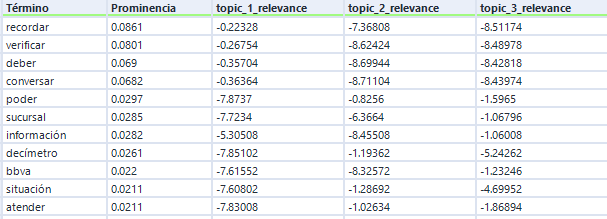

Resumen de palabras por relevancia

Este resumen es una versión con los datos de la visualización, nos devuelve dos métricas: relevancia (relevance) y prominencia (saliency).

Prominencia

Nos ayuda a identificar las palabras que son más informativas para identificar tópicos dentro de los documentos. Un valor de prominencia mayor indica que una palabra es más útil para identificar un tópico específico.

La prominencia es siempre un valor positivo y no tiene un máximo. Un valor de 0 nos indica que una palabra está presente en todos los tópicos. La prominencia está diseñada para ver palabras específicas en relación a la totalidad de documentos que estamos analizando.

Relevancia

Es una métrica usada para ordenar palabras dentro de los tópicos. Nos ayuda a identificar las palabras más relevantes para cada tópico, es un reflejo del nivel en el que una palabra pertenece a un tópico. Entre mayor sea el valor para un tópico dado, esa palabra será más exclusiva para ese tópico.

Ambas métricas muestran valores relativos que podemos utilizar para describir y entender un tópico específico.

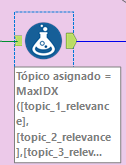

Asignar etiquetas a los tópicos

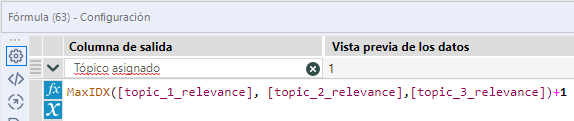

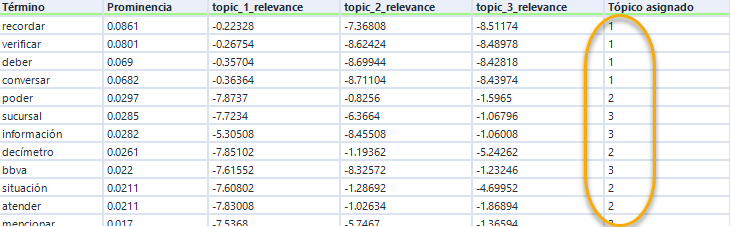

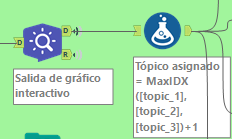

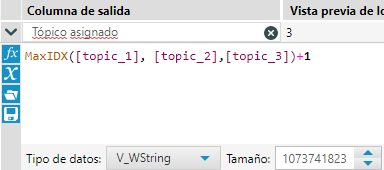

Para facilitar el proceso de asignar etiquetas a los tópicos podemos seleccionar la salida R del modelado de tópicos, ejecutarla y agregarle un bloque analítico de formula a continuación para poder tomar el tópico al que pertenece cada palabra.

La formula MaxIDX nos dará como resultado el número máximo entre los 3 campos, para que sea un entero el resultado, al final le sumamos 1.

De esta forma tendremos asignado un tópico para cada palabra, junto con su prominencia.

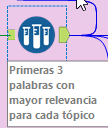

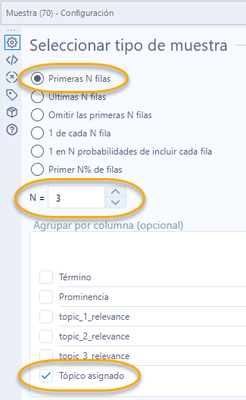

El siguiente paso es agregar un bloque analítico de muestreo que nos permita seleccionar solo las primeras N palabras de cada tópico que creamos.

Y así obtenemos las 3 palabras más prominentes y relevantes.

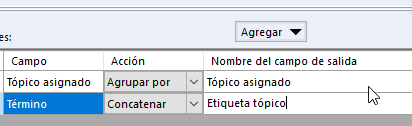

El siguiente paso es crear las etiquetas basados en los términos. Para hacerlo de forma automatizada podemos crear un sumarizado que concatene las 3 palabras para que sirvan de etiqueta para el tópico.

Usando un bloque analítico de sumarizado lo haremos.

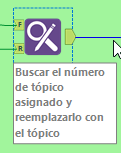

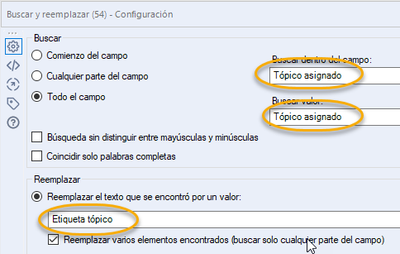

Utilizando un bloque de buscar y reemplazar podemos cambiar los números de tópico por etiquetas que tengan más sentido para los usuarios de negocio que consuman este análisis.

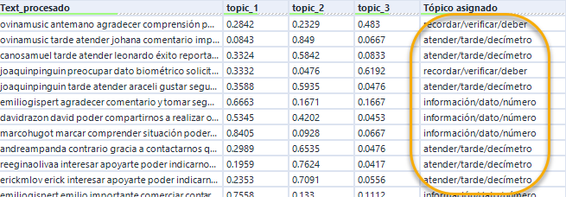

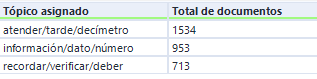

Ahora ya tenemos cada documento etiquetado con el tópico que le pertenece. Con eso podemos sumarizar los tópicos para contar cuántos documentos pertenecen a cada categoría.

Visualizar cada tema en una nube de palabras personalizada

Ahora para categorizar cada documento dentro de su tópico, haremos un proceso similar.

Tomando la salida D del modelado de tópicos, le agregamos un bloque de formula.

Aplicamos la formula para obtener el tópico que tenga la mayor relevancia para cada documento.

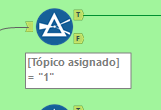

Filtramos cada tópico para poder visualizarlo de forma independiente.

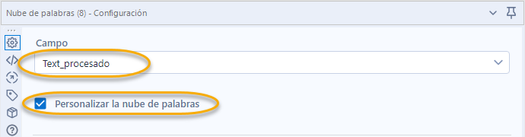

Utilizando el bloque analítico nube palabras, configuramos la visualización.

Primero seleccionamos el campo que queremos visualizar. Si queremos personalizar la nube de palabras, seleccionamos la opción correspondiente.

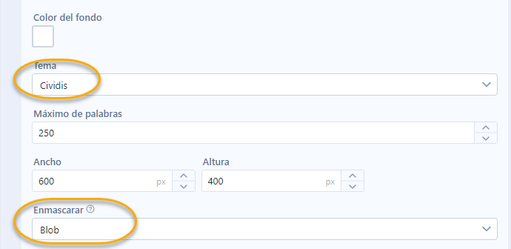

Para personalizar la nube tenemos varias posibilidades.

Podemos elegir un color para el fondo.

Seleccionar el máximo de palabras que tomará.

Cambiar el tamaño.

Y enmascararla, eso quiere decir que podemos una imagen como un logotipo para que la nube se muestre con esa forma.

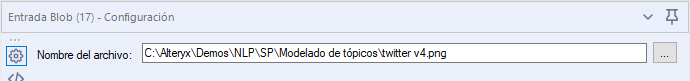

Para que tome una imagen como plantilla tenemos que agregar un bloque de entrada BLOB (binary large object) de la categoría desarrollador y seleccionar la ruta donde se encuentra el archivo.

Una vez hecho esto, en la configuración de la nube de palabras nos aparecerá la opción de Blob en la opción de enmascarar. Una vez ejecutado el flujo, la nube de palabras se presenta.

En este caso yo utilicé una imagen de twitter para darle forma al reporte.

La imagen que utilicé como plantilla es la siguiente.

De esta forma es más sencillo de consumir el análisis de tópicos y hacerlo de forma automática para aprovechar todo el potencial de la plataforma para Automatización de Procesos Analíticos.

Espero este artículo sea interesante y de utilidad para ustedes.

Ahora, bailemos un poco.

Debe ser un usuario registrado para añadir un comentario aquí. Si ya está registrado, inicie sesión. Si todavía no está registrado, hágalo e inicie sesión.

-

20.4

1 -

2019.1

1 -

2019.4

3 -

2020.3

1 -

2021

1 -

2021.1

2 -

2021.2

1 -

2021.3

1 -

2021.4

1 -

2022.1

1 -

2022.3

2 -

2024.1

1 -

@AlteryxOSS

1 -

abril

1 -

abrir el archivo más reciente

1 -

abrir varias hojas

1 -

abrir varios archivos

1 -

Academia

1 -

ACE Program

1 -

activar licencias

1 -

Advanced Analytics

1 -

AED

2 -

agregar macros a Designer

1 -

agregar macros a la paleta de bloques en designer

1 -

agregar macros a la paleta de herramientas de designer

1 -

agregar macros a la paleta de herramientas en designer

1 -

agrupación de temas

2 -

AI

1 -

ALTER.NEXT

1 -

Alteryx

16 -

Alteryx 2020.1

1 -

Alteryx Analytics

2 -

Alteryx Analytics Hub

1 -

Alteryx automation

1 -

alteryx beta program

1 -

Alteryx Designer

4 -

Alteryx Excellence Awards

1 -

Alteryx Gallery

1 -

Alteryx intelligence suite

6 -

alteryx multi-threaded processing engine

1 -

alteryx open source

1 -

Alteryx public gallery

1 -

Alteryx Server

3 -

AlteryxLATAM

1 -

AML

3 -

AMP

1 -

AMP Engine

2 -

Analisis

1 -

Analitica

1 -

analytical apps

2 -

Analyticon

1 -

Analyticon 2021

1 -

Analytics

1 -

Analytics Hub

1 -

analítica

3 -

analítica de autoservicio

3 -

Análisis de Datos

1 -

análisis exploratorio

2 -

APA

3 -

aplicaciones analíticas

2 -

aprendizaje automática

1 -

aprendizaje automático

4 -

aprendizaje automático automatizado

1 -

aprendizaje automático de Alteryx

3 -

Artificial Intelligence

3 -

asociación

1 -

Assisted modeling

1 -

ateryx add-on

1 -

atualización

1 -

augmented intelligence

1 -

Auto Insights

1 -

Automation

1 -

Automatización

1 -

AutoML

1 -

badges

1 -

baja tipo de cambio

1 -

bajar archivos

1 -

base de conocimiento

1 -

Batch Macro

1 -

beta

1 -

biblioteca

1 -

Big Data

1 -

Big Data Analytics

1 -

big query

1 -

build features

1 -

buscar y reemplazar

1 -

Business Intelligence

1 -

Cadena de Suministro

1 -

Características nuevas

1 -

carga masiva

1 -

cargador

1 -

Certificación Alteryx Designer Core

1 -

certificación Core

5 -

cfo

3 -

chatbots

1 -

ChatGPT

1 -

Ciencia de datos

2 -

ciudadano científico de datos

1 -

clasificación de imágenes

2 -

Cloud

1 -

cluster de palabras

1 -

clusters de palabras

1 -

clusters de temas

1 -

comenzar Alteryx

1 -

Community

1 -

Compose

1 -

conector big query

1 -

conector google big query

1 -

conectores

1 -

conexión con API

1 -

configurar Alteryx

1 -

core certification

4 -

Core Certified

3 -

core exam

1 -

credly

1 -

Customer Advocacy

1 -

código abierto

1 -

Data

1 -

data health

1 -

Data Connection Manager

1 -

Database

1 -

Database Connection

1 -

datos

1 -

datos masivos

1 -

Deep Learning

1 -

descarga de archivos

1 -

descarga de la web

1 -

descarga tipo de cambio diario

1 -

Descargar

1 -

descargar archivo html

1 -

descargar macros

1 -

Designer

5 -

Desktop Automation

1 -

Digital

1 -

Digital Badge Program

1 -

download data

1 -

download tool

1 -

EDA

2 -

ejecutar flujos desde línea de comandos

1 -

EMEA

1 -

enero

1 -

Engine

1 -

entrada de datos

1 -

entrada dinámica

1 -

Error

1 -

error 3274

1 -

error al abrir Excel

1 -

error al abrir reportes de SAP

1 -

error en archivos de Excel

1 -

Etiquetas: Leer Excel

1 -

evento

1 -

eventos

16 -

Events

2 -

Excel

1 -

Excel Users

2 -

exceles

1 -

Expresiones Escritas

1 -

extracción de texto

1 -

extraer datos

2 -

feature engineering

3 -

feature type

1 -

Featuretools

1 -

Finanzas

5 -

flujos automatizados

1 -

flujos automáticos

1 -

FTP

1 -

Fuentes de Datos

1 -

galería Alteryx

1 -

galería pública

1 -

Gallery

1 -

generación de características

1 -

geoespacial

1 -

geospatial

1 -

Grand Prix

1 -

grupo de usuarios

1 -

grupos de palabras

2 -

grupos de temas

1 -

identificación de defectos

2 -

identificación de fallas

2 -

identificación de temas

2 -

identificación de tópicos

1 -

imagen a texto

1 -

información

1 -

ingeniería de características

4 -

iniciar sesión

1 -

Innovator

1 -

Inspire

4 -

Inspire EMEA

1 -

instalar Alteryx

1 -

instalar intelligence suite

1 -

instalar IS

1 -

instalar licencias

1 -

Instalar macros en Designer

1 -

Inteligencia artificial

3 -

inteligencia aumentada

1 -

Intelligence Suite

9 -

lanzamiento

1 -

LATAM

2 -

lectura de pdf

1 -

leer imágenes

1 -

leer pdf

1 -

leer un rango

1 -

licencia Alteryx

1 -

licencias alteryx

1 -

limpieza de datos

2 -

login

1 -

línea de comandos

1 -

Machine Learning

5 -

Macro

2 -

Macro batch

1 -

macro estándar

1 -

Macros

2 -

Map

1 -

maps

1 -

maps not showing

1 -

Marketing

1 -

marzo

1 -

mi equipo se murió

1 -

minería de texto

1 -

modelado asistido

2 -

modelado de temas

1 -

modelado de tópicos

2 -

modelado predictivo

3 -

modelo de clasificación entrenado

1 -

modelo de exportación

1 -

motor

1 -

motor de procesamiento paralelo

1 -

mover licencia

1 -

múltiples archivos de Excel

1 -

múltiples Excel

1 -

múltiples exceles

1 -

New release

2 -

News

1 -

NLP

2 -

no aparecen los mapas

1 -

no puedo abrir archivo de Excel

1 -

no puedo entrar

1 -

no se ve el mapa

1 -

no se ven los mapas

1 -

no tengo mapas

1 -

Noticias

1 -

noviembre

1 -

nube de palabras

2 -

nueva versión

3 -

OCR

3 -

octubre

1 -

On-demand

1 -

OpenAI

1 -

OSS

1 -

perfilado de datos

2 -

Performance

1 -

plantillas de pdf

1 -

PLN

2 -

prejudice

1 -

prejuicios

1 -

premios

1 -

Preparación de datos

2 -

preparar archivo html

1 -

preprocesamiento de texto

2 -

preview

1 -

primeros pasos Alteryx

1 -

procesamiento de lenguaje natural

2 -

procesamiento paralelo

1 -

programa Beta

1 -

Public Gallery

1 -

Python

2 -

reconocimiento de imágenes

2 -

reconocimiento de texto

2 -

Regex

2 -

Reports

1 -

Resultado

1 -

revocar licencia

1 -

rpa

1 -

Run Command

1 -

run workflows from command line

1 -

salud de los datos

1 -

segregación

2 -

según demanda

1 -

separación de imágenes

2 -

Server

1 -

SFTP

1 -

Snowflake

2 -

SSO

1 -

tableau public

1 -

Text Mining

1 -

texto no estructurado

1 -

texto semiestructurado

1 -

Tip de la Semana

1 -

tipo de cambio Banxico

1 -

tipo de cambio diario

1 -

tipos de características

1 -

Tips + Tricks

1 -

Tools

2 -

top colaboradores

3 -

Top Contributors

2 -

topic modeling

1 -

Transformación digital

2 -

Transformation

1 -

tricks

1 -

trucos

1 -

varios archivos de Excel

1 -

versión 2020.3

1 -

versión 2020.4

1 -

versión 2021.2

1 -

versión más reciente

1 -

VGI

1 -

Virtual Global Inspire

1 -

visión artificial

1 -

visualización de datos

2 -

Visualization

1 -

Webinar

7 -

webinars

4 -

Word cloud

1 -

Workflow

5 -

Writing Expressions

1

- « Anterior

- Siguiente »

-

Garabujo7 en: Nueva macro para entrenar modelos de ML con restri...

-

Garabujo7 en: Tip de la Semana (14) - Los contenedores

- BorjaR en: Tip de la Semana (13) - Macros por Lotes o Batch ...

-

anguiano en: Hay vida más allá de los dashboards - Introducción...

-

Garabujo7 en: Macro ChatGPT para resolver tareas comunes de Alte...

-

Garabujo7 en: Tip de la Semana(9) -¿Buscando la Velocidad? II-Ef...

- mpost en: ¿Qué es Alteryx?

-

Garabujo7 en: Cómo deshacerse del error de metadatos no válidos ...

- mpost en: TOP COLABORADORES - Q4 2021

-

FláviaB en: Alteryx Analytics Gallery se mudará a la Comunidad