Forum

Trouvez des réponses, posez des questions, et partagez votre expertise d’Alteryx.TIPS de la semaine

Chaque semaine, découvrez de nouvelles astuces et bonnes pratiques pour devenir un expert !

Voir l'index- Community

- :

- Communauté

- :

- Participer

- :

- Forum

- :

- Optimisation Traitement BDD

Optimisation Traitement BDD

- S'abonner au fil RSS

- Marquer le sujet comme nouveau

- Marquer le sujet comme lu

- Placer ce Sujet en tête de liste pour l'utilisateur actuel

- Marquer

- S'abonner

- Sourdine

- Page imprimable

- Marquer comme nouveau

- Marquer

- S'abonner

- Sourdine

- S'abonner au fil RSS

- Surligner

- Imprimer

- Signaler au modérateur

Bonjour,

Je dispose d'un dataset constitué de plusieurs archives (10 fichiers .gz de 1,4 Go).

Ce dataset n'a pas d'entête de colonne et compte près de 2 000 colonnes.

Je récupère les noms des colonnes (à partir d'un fichier de dessin) les affecte aux colonnes, je conserve uniquement les colonnes qui me sont utiles. J'utilise aussi un fichier de configuration pour optimiser le typage et la taille des champs produit avec l'objet Champ automatique.

Et je mets ça dans une base PostgreSQL (autant de ligne sur 600 colonnes environ).

Jusque là, tout va bien, le job est fait mais j'observe une durée de traitement relativement longue.

Ca prend un peu plus de 3h pour réaliser ces opérations en insertion en masse (PostgreSQL bulk Loader).

Je voudrais savoir si il ne serait pas possible d'optimiser ce traitement pour faire gagner du temps à ce traitement.

Cordialement,

Résolu ! Accéder à la solution.

- Marquer comme nouveau

- Marquer

- S'abonner

- Sourdine

- S'abonner au fil RSS

- Surligner

- Imprimer

- Signaler au modérateur

@David_1 : tu pourrais peut-être monter tes données dans PostrGreSQL dès le départ pour ensuite utiliser les outils in-db qui délègueront les transformations à la base de données ?

- Marquer comme nouveau

- Marquer

- S'abonner

- Sourdine

- S'abonner au fil RSS

- Surligner

- Imprimer

- Signaler au modérateur

Salut @David_1

Quelle version de votre Alteryx ?

Quelle est la version de votre pilote (odbc/oledb) pour postgree ?

Vous pouvez jeter un œil à ce lien, il contient peut-être des informations qui vous aideront.

Salutations

- Marquer comme nouveau

- Marquer

- S'abonner

- Sourdine

- S'abonner au fil RSS

- Surligner

- Imprimer

- Signaler au modérateur

Hello @David_1 ,

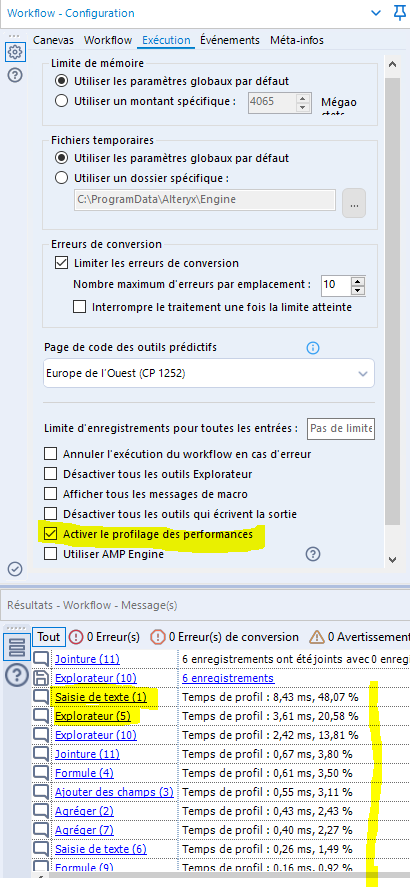

Pour mieux comprendre où est consommé le temps lors d'un traitement tu peux activier l'option "Activer l'option de profilage" dans le menu Exécution de ton workflow.

ceci rajoute à la fin de tes logs la liste des objets avec le temps en % passé sur chacun d'eux. Tu peux donc voir si le temps est passé en lecture écriture... ou autre.

Du coup cela t'aide à voir si c'est la conversion du Zip qui prends du temps, l'écriture dans PostGre...et ainsi investiguer sur ces postes particuliers.

Est ce mon poste qui mérite d'être amélioré (si c'est sur l'extraction, nettoyage des zips), est ce le driver en écriture (si c'est l'écriture PostGre)...

Il peut aussi être intéressant de tester dézippé pour voir la part que le zip prends dans l'exécution.

Et après effectivement de réfléchir à des solutions alternatives.

Hope it helps.

Bye

Sales Engineer

Alteryx

- Marquer comme nouveau

- Marquer

- S'abonner

- Sourdine

- S'abonner au fil RSS

- Surligner

- Imprimer

- Signaler au modérateur

Merci à Toons et Carlos pour vos propositions.

L'option proposée par Toons me fait consommer beaucoup plus d'espace disk. Je suis en phase de POC pour l'instant et je n'ai pas forcement l'infrastructure que va avec.

Bien que l'option de Carlos nous renvoie sur une problématique SQL Server, c'est déjà un levier que j'utilise en pré-requête SQL de mon mass loader :

ALTER TABLE nom_de_table SET UNLOGGED;

TRUNCATE nom_de_table;

L'option proposée par Stéphane m'a permis de réduire un peu la durée du traitement en voyant que mes transformations sur le fichier gz prenaient +/- 25% du temps. J'ai donc corrigé mon workflow.

J'ai fait des tests avec d'autres outils aussi.

C'est surtout la lecture et la transformation qui pèsent dans le traitement. L'écriture en base prend à peine 1 heure.

J'en arrive à la conclusion que travailler quelques 26 millions de lignes sur 650 colonnes, et de les pousser en base, ca prend du temps.

Merci à tous,

- Marquer comme nouveau

- Marquer

- S'abonner

- Sourdine

- S'abonner au fil RSS

- Surligner

- Imprimer

- Signaler au modérateur

Bonjour @David_1,

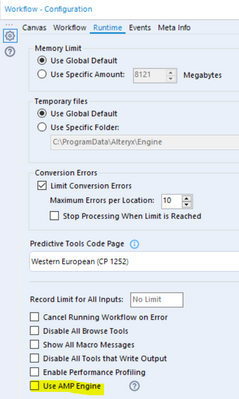

En complément des réponses très pertinentes que tu as déjà reçu, as-tu fais des tests avec le moteur AMP :

Nous obtenons de beau gain en fonction du workflow et des outils utilisés : https://community.alteryx.com/t5/Engine-Works/AMPlify-your-Workflows/ba-p/617590

- Marquer comme nouveau

- Marquer

- S'abonner

- Sourdine

- S'abonner au fil RSS

- Surligner

- Imprimer

- Signaler au modérateur

Bonjour mathieuf,

Merci pour ton suivi.

Effectivement j'utilise la fonctionnalité AMP pour ma partie Data Préparation.

J'ai compartimenté mes tâches :

1. Récupération des archives sur sftp et décompression en local (10 x 1,5Go qui deviennent 10 x 13Go) : 45 min

2. Lecture des fichiers et nettoyage (attribution de noms d'entête, sélection de colonnes, normalisation de certaines colonnes) : 1h50

=> pour cette partie là, l'AMP engine apporte beaucoup

=> j'ai aussi modifié la mémoire allouée au traitement en ajustant le paramètre à 8Go (au lieu des 2Go / 4Go par défaut)

=> les résultats de la data prép sont stockés aux formats optimises Database Alteryx (.yxdb) (10 x 3Go)

3. Mise en base des datasets via un bulk postgresql : 1h23

=> truncate table

=> drop des index

=> insert des lignes

=> création des index

Pour mémoire on est sur une base de 27 millions de lignes x 580 colonnes.

Dans l'idéal, je suis en "négo" pour accéder à un fichier différentiel. Ce qui serait bien plus optimum à mon sens.

Et par ailleurs, je test aussi une mise en base dans une mongo. Mais là faut que je réfléchisse encore un peu au modèle de données, en fonction des applications à mettre en place derrière.

Après, tous les prétextes sont bons pour éprouver les fonctionnalités d'Alteryx 😁. A chaque fois je constate que le potentiel de l'outil est énorme !!!😍😍😍

A+

- Marquer comme nouveau

- Marquer

- S'abonner

- Sourdine

- S'abonner au fil RSS

- Surligner

- Imprimer

- Signaler au modérateur

Bonjour @David_1,

Merci beaucoup pour ta participation au forum et ta question !

Si les réponses de @mathieuf , @StephaneP , @carlosteixeira , @Toons t'ont aidé, pourrais-tu les "Accepter comme solution", tu aideras ainsi d'autres utilisateurs Alteryx.

Merci beaucoup à toi et une très bonne journée !

-

Academy

7 -

Academy française Alteryx

1 -

ACE

2 -

ADAPT

1 -

Agenda

6 -

Agréger

1 -

Ajouter des champs

1 -

Alert

1 -

Alteryx Designer

5 -

Alteryx Designer Expert

1 -

Alteryx Engine

1 -

Alteryx Excellence Awards

1 -

Alteryx User Groups

4 -

analyse avancée

1 -

Analyse de données

1 -

Analyse predictive

1 -

analyses avancées

1 -

anomalie

1 -

API

1 -

App et macros

1 -

Append Fields

1 -

application analytique

1 -

Applications

1 -

Apprentissage

1 -

astuce

5 -

Astuce quotidienne

42 -

automatique

1 -

automatisation

1 -

autorisation

1 -

Autosave

1 -

Azure

1 -

BDD

1 -

Best Practices

1 -

Bienvenue

1 -

Binary File

1 -

blog

1 -

Bug

1 -

Cahier de vacances

1 -

Canada

1 -

Cas d'usage

1 -

Centre de Solution Virtuel

1 -

Centre de Solution Virtuel français

1 -

Certification

1 -

Certification Alteryx Designer Core

1 -

certifiés

2 -

Champagne et Analytics

1 -

citizen data

1 -

combinaison

1 -

communauté francophone

1 -

Community

1 -

comptabilité

1 -

Connect a file or a Database

1 -

connecteur

1 -

connecteur Salesforce

1 -

Connecteurs

6 -

Connector

5 -

Connectors

2 -

Connexion de base de données

1 -

containers

1 -

convert

1 -

Core

2 -

Correspondances partielles

1 -

COVID-19

2 -

CREW Macros

1 -

CRM

1 -

cryptage

1 -

Data Analyse

1 -

Data Analytics

1 -

Data Cleansing

1 -

Data Science

1 -

Data Science Learning Path

1 -

Data Science Portal

1 -

Date

2 -

Date Time

1 -

DateHeure

1 -

datetimeparse

1 -

Designer

4 -

DFO

1 -

Documentation

1 -

domaine

1 -

données spatiales

1 -

download tool

1 -

défi

1 -

Défi hebdomadaire

68 -

Défis Hebdomadaires

3 -

Dépivoter

1 -

E-book

1 -

eau

1 -

Email

1 -

Emailing

1 -

Entrée de données

1 -

Entrée dynamique

1 -

Error

1 -

Error Message

2 -

Event

3 -

Events

1 -

Excel

2 -

fichier

1 -

fichiers

1 -

Field Info

1 -

Filter

1 -

finance

1 -

fiscalité

1 -

Fiscalité Analytique

1 -

Format de Date

1 -

Formula

1 -

Formule

2 -

Formule à plusieurs lignes

1 -

français

1 -

Fuzzy Matching

1 -

General

1 -

geocoding

1 -

geometry

1 -

grouping

1 -

généraliser

1 -

générer des lignes

1 -

Help

1 -

Hex

1 -

Hubday Data

1 -

idées

2 -

Index

4 -

infrastructure

1 -

Input data

1 -

Input Output

1 -

Inspire

2 -

Interface

1 -

Interface Tools

1 -

Intermédiaire

1 -

INTRACO

1 -

Issue

1 -

jeu de données analytique

1 -

Joindre des données

1 -

Jointure

2 -

Jointure vs Union

1 -

leçons interactives

4 -

List Runner

1 -

Machine Learning

1 -

Macro

2 -

Macros

2 -

mail

1 -

Maitrise de la fonction

1 -

Matoya

1 -

Maîtrise de l'outil

1 -

Memory

1 -

Message

1 -

Microsoft Azure Storage

1 -

Microsoft dynamics for operations 365

1 -

mise a jour

1 -

MongoDB

1 -

montréal

1 -

moteur AMP

1 -

MST

1 -

Nettoyage de données

1 -

network

1 -

olivier.catoir-ext@Lexisnexis.fr

1 -

onglet

1 -

Optimisation

1 -

Optimization

2 -

Outil

1 -

outils

2 -

Output

1 -

Output Data

1 -

package

1 -

partage

2 -

Petit Prix

1 -

Plusieurs jointures

1 -

Podcast

2 -

post

1 -

Power BI

3 -

power bi output

1 -

Powershell

1 -

Predictive

1 -

Prim's

1 -

propriété intellectuelle

1 -

Préparation des données

1 -

Python

1 -

Questions pour un outil

130 -

rang

1 -

Rechercher et remplacer

1 -

RegEx

3 -

renommer

2 -

Replay

10 -

REPLAY WEBINAIRE

1 -

reporting tools

1 -

Ressources

1 -

Retail

1 -

RH

1 -

Run Workflows

1 -

Saisie de texte

1 -

Salesforce

3 -

Santalytics

1 -

sauvegarde

1 -

Scientist

1 -

selection

1 -

serie

1 -

Server

1 -

SIRET

1 -

size limit .yxdb

1 -

Solve From Home

1 -

SOMMER

1 -

sondage

1 -

Sortie de données

1 -

Sortie données

1 -

source

1 -

sources

1 -

spanning tree

1 -

Spatial

2 -

SQL Agent

1 -

SQL Server

1 -

Summarize

1 -

survey

1 -

Sélectionner

2 -

Tableau

1 -

Tableau croisé dynamique

1 -

taxe

1 -

test

1 -

Texte en colonnes

1 -

The Data Podcast

1 -

Tips

1 -

Tips de la semaine

3 -

togetherwesolve

1 -

top

1 -

Top Contributeur

1 -

Top Contributeurs

4 -

Top Contributors

1 -

Transposer

1 -

tri

1 -

Trier

1 -

trigger

1 -

Trivia

9 -

TVA

1 -

Télécharger

1 -

Union

2 -

Unique

1 -

Unknown

1 -

Update

1 -

Updates

1 -

Upgrades

1 -

URL

1 -

user group

4 -

User Groups

2 -

version 2019.4

1 -

vidéos interactives

1 -

Virtual Solution Center

1 -

Webconférence

1 -

webinaire

14 -

Webinaires

2 -

Webinar

3 -

Wildcard

1 -

Workflow

5 -

workflow performant

1 -

Workflows

1 -

Write

1 -

writing expression

1 -

Writing Expressions

1 -

Échantillon

1 -

Écrire des expressions

1

- « Précédent

- Suivant »