Blog

Visiones e ideas de las mentes más brillantes en el campo del análisis.- Suscribirse a un feed RSS

- Marcar como nuevo

- Marcar como leída

- Favorito

- Suscribir

- Página de impresión sencilla

- Notificar al moderador

- Suscribirse a un feed RSS

- Marcar como nuevo

- Marcar como leída

- Favorito

- Suscribir

- Página de impresión sencilla

- Notificar al moderador

Se dice que una de las ventajas de la inteligencia artificial o de las evaluaciones mediante modelos analíticos es que no tienen en cuenta prejuicios como los tenemos las personas, por tratarse de máquinas que solo responden de acuerdo a los datos que reciben sin tomar en cuenta otros elementos que podrían alterar su juicio.

Como en el caso de los humanos, estamos influenciados por la cultura, el estado de ánimo, los gustos y vivencias que hayamos tenido para dar un juicio de valor sobre un tema o una persona, lo que nos hace tendientes a tener visiones sesgadas.

Los modelos matemáticos, el aprendizaje automático, las redes neuronales o los procesadores de lenguaje natural no lo están como nosotros, sin embargo ¿qué es lo que sucede para que se presenten casos de prejuicio o discriminación por parte de sistemas de inteligencia artificial?

Datos

Para entrenar o enseñarle a cualquier modelo estadístico o matemático, que son la base de la inteligencia artificial, debemos usar datos.

Ya sea históricos de lo que ha sucedido si queremos predecir cuáles clientes dejarán de pagar una deuda o cuáles son compradores potenciales de mi producto, requerimos historial, donde el evento que busco predecir se haya presentado anteriormente para poder extrapolar sus características y determinar la capacidad predictiva que cada una de las variables tiene para el objetivo deseado.

Se requieren datos y tienen que ser con la mayor variedad posible para una mejor predicción y comprensión del fenómeno.

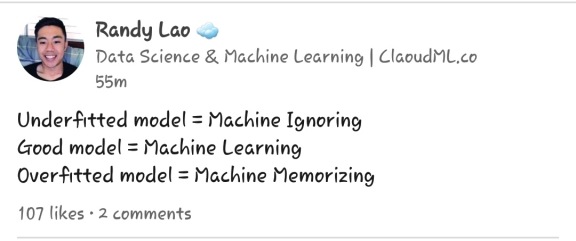

Tomando esto como base y dependiendo de los datos que ingresemos a la máquina, además de las técnicas que utilicemos, podemos llegar a tres posibles resultados en los modelos:

1. Sub-ajustado, en el que la máquina no tomará en cuenta los datos y dará conclusiones genéricas y sin sustento

2. Adecuado, en el que se dará aprendizaje automático ya que utilizará los datos presentes para extrapolarlos y será capaz de predecir resultados con alta probabilidad y efectividad

3. Sobre-ajustado, en el que la máquina memoriza los datos y da resultados excepcionales en todos los casos

Los 3 tipos de resultados de un modelo

Los 3 tipos de resultados de un modelo

Los tres tipos de resultados de un modelo

Debido a que la máquina aprende basada en los datos que ingresamos, debe tomarlos en cuenta y dar resultados basados en ellos, no al pie de la letra ni sin la base de ellos, por eso es importante la cantidad y calidad de los que se utilicen así como la sistematización para aplicarlos y prepararlos.

Sesgo

Entonces, si la computadora aprende basada en los datos que le proporcionamos y con base en ellos extrapola sus propias reglas (si se trata de aprendizaje automático) o compara y toma similitudes basadas en grupos que nosotros les damos como en el caso del aprendizaje en profundidad o el procesamiento de lenguaje natural.

El caso es que para aprender toman en cuenta información inicial que les sirve de punto de partida.

Y si las conclusiones a las que llegan tienen tintes racistas, discriminatorios o xenófobos. ¿Cómo es que la máquina llego a ellos si no posee prejuicios ni ideas preconcebidas?

En la mayoría de los casos se debe a que en la fase de entrenamiento de la inteligencia artificial y de los modelos estadísticos que la sustentan se utilizan datos sesgados o los desarrolladores imprimen sus propios prejuicios a través de la información que alimentan.

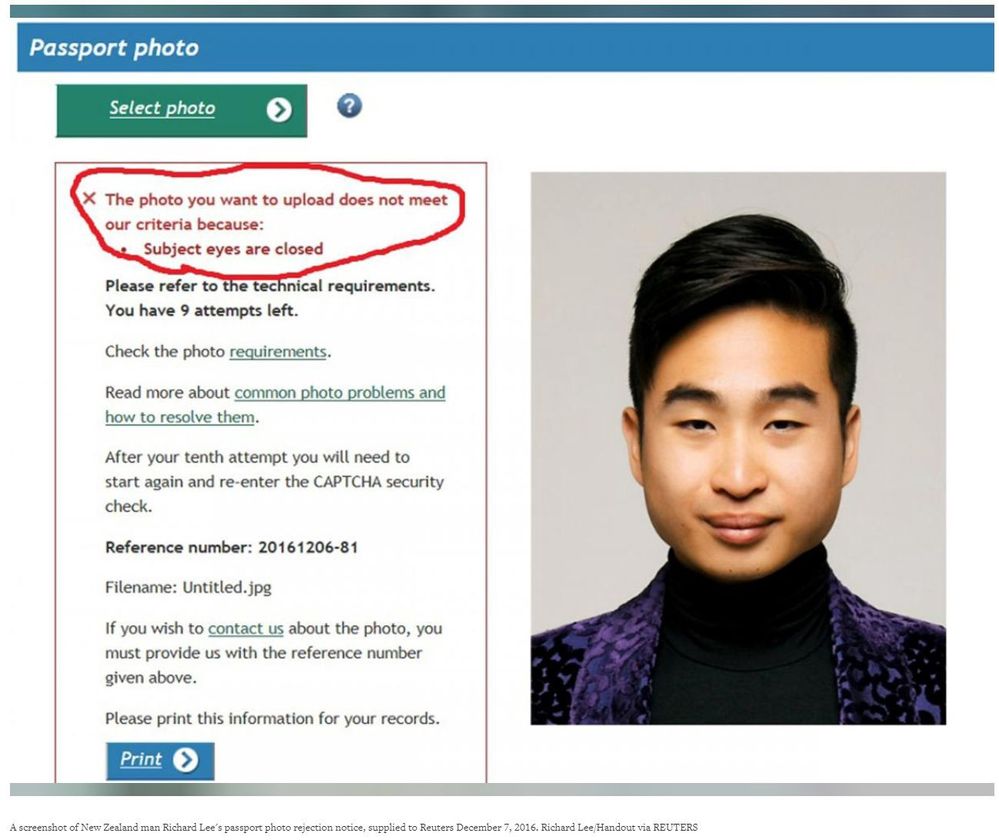

Tenemos el caso del sistema de pasaportes de Nueva Zelanda en el que puedes tomar tu foto y subirla al sistema para utilizarla.

Sin embargo, un usuario tuvo problemas para que aceptara su foto porque el sistema determinó que tenía los ojos cerrados y eso era incorrecto.

El usuario realmente tenía los ojos abiertos pero el sistema no lo aceptaba y lo rechazaba.

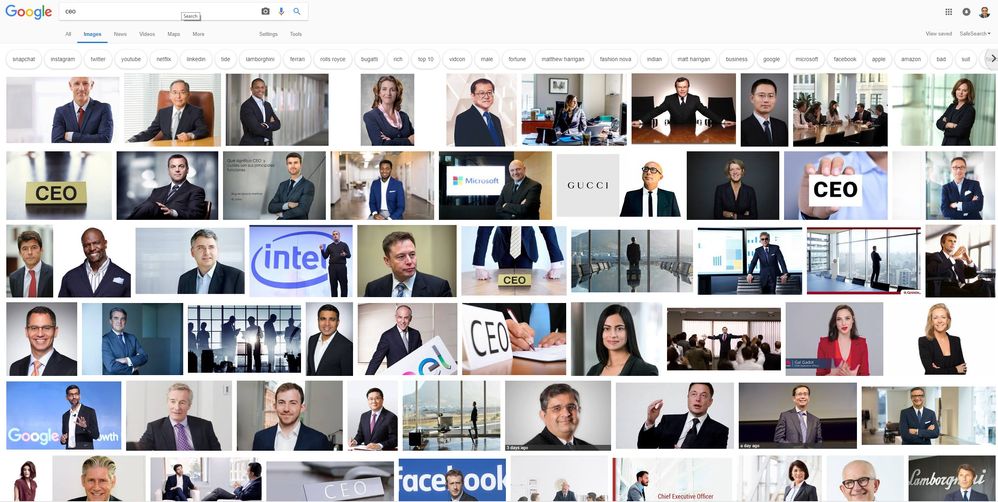

Otra situación donde podemos ver cómo se mantienen los prejuicios en los datos y se pasan a las máquinas, si esos mismos datos se usan para entrenarlas, es cuando hacemos búsquedas en Google.

Si queremos imágenes de CEO o presidentes de compañías, lo que nos muestra son principalmente hombres. Entonces si creáramos un modelo que ayudara a reclutar y calificar candidatos a esta posición, posiblemente estaría inclinado hacia los hombres, debido a que la palabra se asocia principalmente con ellos.

Resultados de búsqueda de la palabra CEO en Google

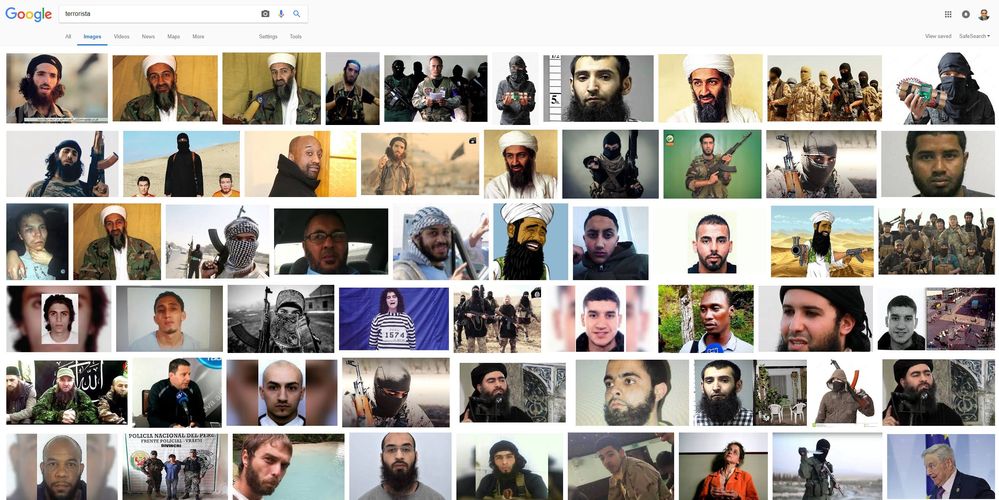

De la misma manera si buscamos terrorista, nos muestra las siguientes imágenes.

Resultados de búsqueda de la palabra terrorista en Google

Por lo que podríamos asumir con cierta certeza que si una persona es de origen y apariencia árabe entonces será terrorista.

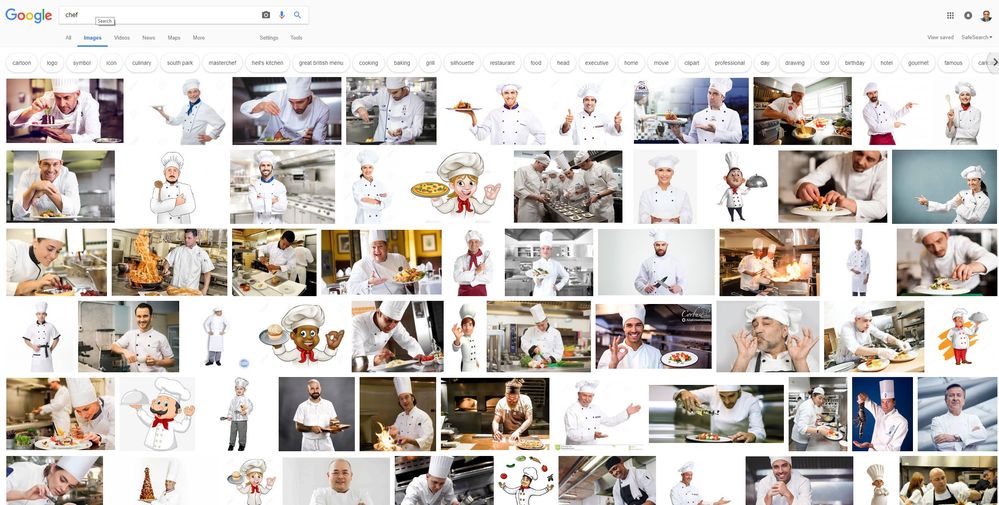

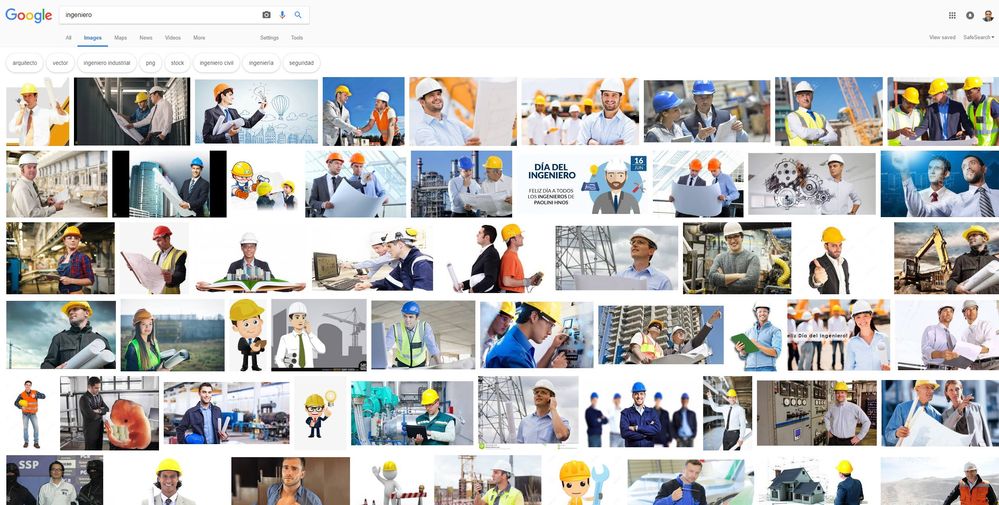

Pasa lo mismo con los términos ingeniero y chef, en los que aparecen principalmente hombres por lo que se pudiera suponer que son profesiones para hombres, lo que es un prejuicio como todos los anteriores.

Resultados de búsqueda de la palabra chef en Google

Muestra de datos

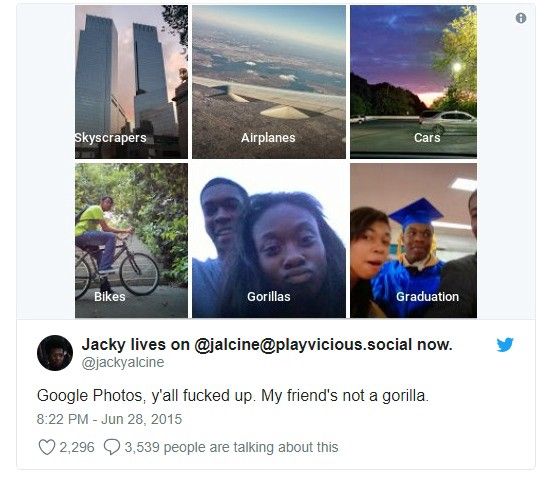

Con esto podemos ver que los datos están cargados hacia los prejuicios que tenemos las personas, eso hace que cuando creamos modelos para predicciones o inteligencia artificial, tengan esos mismos prejuicios de forma implícita y los hagan persistir, ya sea a propósito o porque dentro de los datos existentes tenemos algunos que sólo refuerzan el prejuicio como el caso de la búsqueda de las palabras terrorista, CEO o ingeniero.

Como en la aplicación de fotos de Google que automáticamente clasificó las imágenes de una persona y su novia como gorilas.

Conclusión

Para evitar trasladar los prejuicios de las personas hacia las máquinas debemos tener cuidado con las muestras de datos que utilizamos y los procesos para entrenar los modelos y evitar hacer generalizaciones sobre pocos datos ya que eso nos puede llevar a problemas.

Este es claramente un problema inicial de falta de información y un proceso en el que aún estamos explorando sus alcances y resultados pero es importante empezar a pensar en estos detalles para poder prevenir potenciales fallas en los sistemas de inteligencia artificial.

Debe ser un usuario registrado para añadir un comentario aquí. Si ya está registrado, inicie sesión. Si todavía no está registrado, hágalo e inicie sesión.

-

20.4

1 -

2019.1

1 -

2019.4

3 -

2020.3

1 -

2021

1 -

2021.1

2 -

2021.2

1 -

2021.3

1 -

2021.4

1 -

2022.1

1 -

2022.3

2 -

@AlteryxOSS

1 -

abril

1 -

abrir el archivo más reciente

1 -

abrir varias hojas

1 -

abrir varios archivos

1 -

Academia

1 -

ACE Program

1 -

activar licencias

1 -

Advanced Analytics

1 -

AED

2 -

agregar macros a Designer

1 -

agregar macros a la paleta de bloques en designer

1 -

agregar macros a la paleta de herramientas de designer

1 -

agregar macros a la paleta de herramientas en designer

1 -

agrupación de temas

2 -

AI

1 -

ALTER.NEXT

1 -

Alteryx

16 -

Alteryx 2020.1

1 -

Alteryx Analytics

2 -

Alteryx Analytics Hub

1 -

Alteryx automation

1 -

alteryx beta program

1 -

Alteryx Designer

4 -

Alteryx Excellence Awards

1 -

Alteryx Gallery

1 -

Alteryx intelligence suite

6 -

alteryx multi-threaded processing engine

1 -

alteryx open source

1 -

Alteryx public gallery

1 -

Alteryx Server

2 -

AlteryxLATAM

1 -

AML

3 -

AMP

1 -

AMP Engine

2 -

Analisis

1 -

Analitica

1 -

analytical apps

2 -

Analyticon

1 -

Analyticon 2021

1 -

Analytics

1 -

Analytics Hub

1 -

analítica

3 -

analítica de autoservicio

3 -

Análisis de Datos

1 -

análisis exploratorio

2 -

APA

3 -

aplicaciones analíticas

2 -

aprendizaje automática

1 -

aprendizaje automático

4 -

aprendizaje automático automatizado

1 -

aprendizaje automático de Alteryx

3 -

Artificial Intelligence

3 -

asociación

1 -

Assisted modeling

1 -

ateryx add-on

1 -

atualización

1 -

augmented intelligence

1 -

Auto Insights

1 -

Automation

1 -

Automatización

1 -

AutoML

1 -

badges

1 -

baja tipo de cambio

1 -

bajar archivos

1 -

Batch Macro

1 -

beta

1 -

biblioteca

1 -

Big Data

1 -

Big Data Analytics

1 -

big query

1 -

build features

1 -

buscar y reemplazar

1 -

Business Intelligence

1 -

Cadena de Suministro

1 -

Características nuevas

1 -

carga masiva

1 -

cargador

1 -

Certificación Alteryx Designer Core

1 -

certificación Core

5 -

cfo

3 -

chatbots

1 -

ChatGPT

1 -

Ciencia de datos

2 -

ciudadano científico de datos

1 -

clasificación de imágenes

2 -

Cloud

1 -

cluster de palabras

1 -

clusters de palabras

1 -

clusters de temas

1 -

comenzar Alteryx

1 -

Community

1 -

Compose

1 -

conector big query

1 -

conector google big query

1 -

conectores

1 -

conexión con API

1 -

configurar Alteryx

1 -

core certification

4 -

Core Certified

3 -

core exam

1 -

credly

1 -

Customer Advocacy

1 -

código abierto

1 -

Data

1 -

data health

1 -

Data Connection Manager

1 -

Database

1 -

Database Connection

1 -

datos

1 -

datos masivos

1 -

Deep Learning

1 -

descarga de archivos

1 -

descarga de la web

1 -

descarga tipo de cambio diario

1 -

Descargar

1 -

descargar archivo html

1 -

descargar macros

1 -

Designer

5 -

Desktop Automation

1 -

Digital

1 -

Digital Badge Program

1 -

download data

1 -

download tool

1 -

EDA

2 -

ejecutar flujos desde línea de comandos

1 -

EMEA

1 -

enero

1 -

Engine

1 -

entrada de datos

1 -

entrada dinámica

1 -

Error

1 -

error 3274

1 -

error al abrir Excel

1 -

error al abrir reportes de SAP

1 -

error en archivos de Excel

1 -

Etiquetas: Leer Excel

1 -

evento

1 -

eventos

16 -

Events

2 -

Excel

1 -

Excel Users

2 -

exceles

1 -

Expresiones Escritas

1 -

extracción de texto

1 -

extraer datos

2 -

feature engineering

3 -

feature type

1 -

Featuretools

1 -

Finanzas

5 -

flujos automatizados

1 -

flujos automáticos

1 -

FTP

1 -

Fuentes de Datos

1 -

galería Alteryx

1 -

galería pública

1 -

Gallery

1 -

generación de características

1 -

geoespacial

1 -

geospatial

1 -

Grand Prix

1 -

grupo de usuarios

1 -

grupos de palabras

2 -

grupos de temas

1 -

identificación de defectos

2 -

identificación de fallas

2 -

identificación de temas

2 -

identificación de tópicos

1 -

imagen a texto

1 -

información

1 -

ingeniería de características

4 -

iniciar sesión

1 -

Innovator

1 -

Inspire

4 -

Inspire EMEA

1 -

instalar Alteryx

1 -

instalar intelligence suite

1 -

instalar IS

1 -

instalar licencias

1 -

Instalar macros en Designer

1 -

Inteligencia artificial

3 -

inteligencia aumentada

1 -

Intelligence Suite

9 -

lanzamiento

1 -

LATAM

2 -

lectura de pdf

1 -

leer imágenes

1 -

leer pdf

1 -

leer un rango

1 -

licencia Alteryx

1 -

licencias alteryx

1 -

limpieza de datos

2 -

login

1 -

línea de comandos

1 -

Machine Learning

5 -

Macro

2 -

Macro batch

1 -

macro estándar

1 -

Macros

2 -

Map

1 -

maps

1 -

maps not showing

1 -

Marketing

1 -

marzo

1 -

mi equipo se murió

1 -

minería de texto

1 -

modelado asistido

2 -

modelado de temas

1 -

modelado de tópicos

2 -

modelado predictivo

3 -

modelo de clasificación entrenado

1 -

modelo de exportación

1 -

motor

1 -

motor de procesamiento paralelo

1 -

mover licencia

1 -

múltiples archivos de Excel

1 -

múltiples Excel

1 -

múltiples exceles

1 -

New release

2 -

News

1 -

NLP

2 -

no aparecen los mapas

1 -

no puedo abrir archivo de Excel

1 -

no puedo entrar

1 -

no se ve el mapa

1 -

no se ven los mapas

1 -

no tengo mapas

1 -

Noticias

1 -

noviembre

1 -

nube de palabras

2 -

nueva versión

3 -

OCR

3 -

octubre

1 -

On-demand

1 -

OpenAI

1 -

OSS

1 -

perfilado de datos

2 -

Performance

1 -

plantillas de pdf

1 -

PLN

2 -

prejudice

1 -

prejuicios

1 -

premios

1 -

Preparación de datos

2 -

preparar archivo html

1 -

preprocesamiento de texto

2 -

preview

1 -

primeros pasos Alteryx

1 -

procesamiento de lenguaje natural

2 -

procesamiento paralelo

1 -

programa Beta

1 -

Public Gallery

1 -

Python

2 -

reconocimiento de imágenes

2 -

reconocimiento de texto

2 -

RegEx

2 -

Reports

1 -

Resultado

1 -

revocar licencia

1 -

rpa

1 -

Run Command

1 -

run workflows from command line

1 -

salud de los datos

1 -

segregación

2 -

según demanda

1 -

separación de imágenes

2 -

Server

1 -

SFTP

1 -

Snowflake

2 -

SSO

1 -

tableau public

1 -

Text Mining

1 -

texto no estructurado

1 -

texto semiestructurado

1 -

Tip de la Semana

1 -

tipo de cambio Banxico

1 -

tipo de cambio diario

1 -

tipos de características

1 -

Tips + Tricks

1 -

Tools

2 -

top colaboradores

3 -

Top Contributors

2 -

topic modeling

1 -

Transformación digital

2 -

Transformation

1 -

tricks

1 -

trucos

1 -

varios archivos de Excel

1 -

versión 2020.3

1 -

versión 2020.4

1 -

versión 2021.2

1 -

versión más reciente

1 -

VGI

1 -

Virtual Global Inspire

1 -

visión artificial

1 -

visualización de datos

2 -

Visualization

1 -

Webinar

7 -

webinars

4 -

Word cloud

1 -

Workflow

5 -

Writing Expressions

1

- « Anterior

- Siguiente »

-

Garabujo7 en: Nueva macro para entrenar modelos de ML con restri...

-

Garabujo7 en: Tip de la Semana (14) - Los contenedores

-

BorjaR en: Tip de la Semana (13) - Macros por Lotes o Batch ...

-

anguiano en: Hay vida más allá de los dashboards - Introducción...

-

Garabujo7 en: Macro ChatGPT para resolver tareas comunes de Alte...

-

Garabujo7 en: Tip de la Semana(9) -¿Buscando la Velocidad? II-Ef...

-

mpost en: ¿Qué es Alteryx?

-

Garabujo7 en: Cómo deshacerse del error de metadatos no válidos ...

-

mpost en: TOP COLABORADORES - Q4 2021

-

FláviaB en: Alteryx Analytics Gallery se mudará a la Comunidad